LLM Optimizer permet de:

-

Cartographier la visibilité de la marque dans les réponses génératives;

-

Identifier les opportunités de contenu permettant d’apparaître dans les recommandations IA ;

-

Optimiser la performance commerciale issue de ces nouvelles sources de trafic.

Son fonctionnement s’articule autour de trois piliers :

-

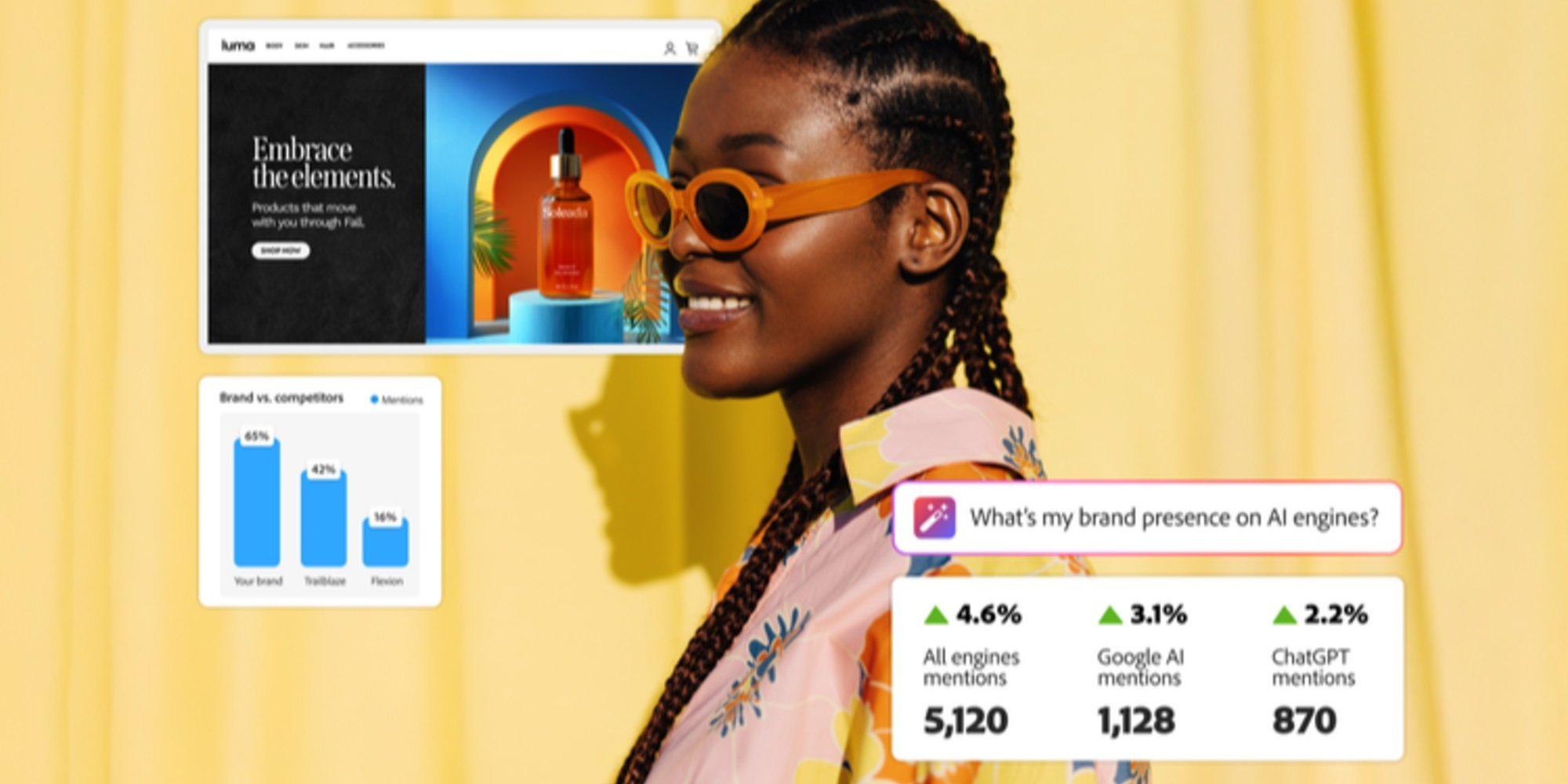

Surveillance du trafic et de la visibilité dans les environnements IA : l’outil détecte les contenus exploités par les assistants conversationnels pour formuler leurs réponses, offrant ainsi aux marques une vision en temps réel de leur présence dans ces interfaces. Une fonctionnalité de benchmarking permet de mesurer cette visibilité face à la concurrence, notamment sur des requêtes stratégiques à forte valeur ajoutée ;

-

Recommandations activables orientées performance : au-delà du diagnostic, LLM Optimizer suggère des actions concrètes : enrichir une FAQ, valoriser une page produit, ou encore renforcer la présence sur des plateformes tierces comme Wikipédia. Le moteur de recommandation s’appuie sur l’analyse des attributs mis en avant par les modèles de langage (structure, clarté, fiabilité…) et relie chaque recommandation à des indicateurs business clés (trafic, engagement, conversion) ;

-

Mise en œuvre rapide via intégrations CMS ou API : pensé pour les équipes SEO, contenu ou marketing digital, LLM Optimizer s’intègre à Adobe Experience Manager Sites mais peut aussi fonctionner de manière autonome. Il prend en charge les protocoles émergents comme Agent-to-Agent (A2A) ou Model Context Protocol (MCP), ce qui facilite son adoption dans des environnements techniques variés.

Cette capacité à agir sur les contenus possédés (sites, FAQ) et gagnés (Wikipédia, forums, bases de connaissances) offre une nouvelle forme d’optimisation : proactive, contextualisée et ajustée aux algorithmes de synthèse.