Article sponsorisé par Fasterize

Si les systèmes évoluent de plus en plus vite, la capacité des équipes SEO à tester et déployer des optimisations reste quant à elle structurellement lente. Le time to market d’une roadmap SEO ne peut plus se faire uniquement sur 12 mois : il faut aussi pouvoir agir en temps réel.

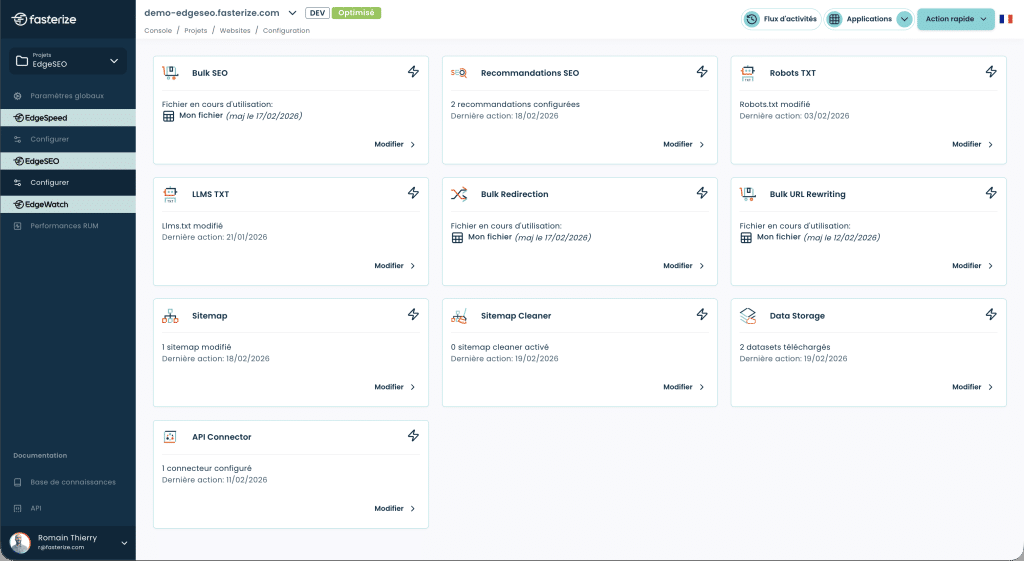

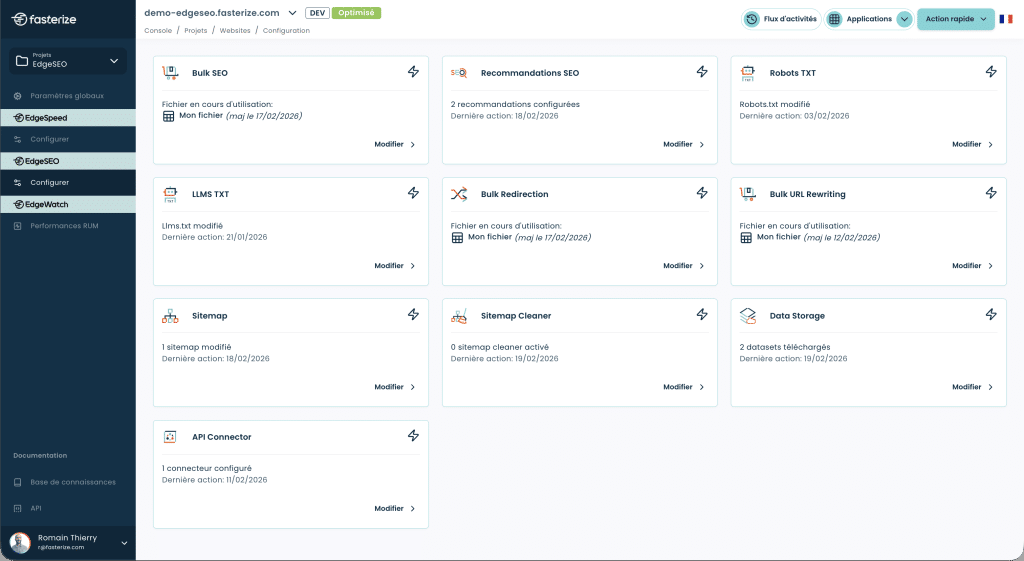

Fasterize redonne la main aux équipes SEO en leur permettant d’implémenter des expérimentations techniques de façon facile et rapide, sans mobiliser constamment les ressources de développement. Cette agilité nouvelle est d’autant plus importante dans un environnement où les moteurs de réponse IA (ChatGPT, Perplexity, Gemini) changent les règles de la visibilité en ligne.

LLMs.txt et bonnes pratiques

Le fichier robots.txt a longtemps été le standard universel pour contrôler l’accès des crawlers. Aujourd’hui, une nouvelle convention émerge : les fichiers /llms.txt et /llms-full.txt, conçus spécifiquement pour guider les agents d’intelligence artificielle. Ces fichiers permettent en théorie de définir des règles claires sur les parties du site accessibles aux LLMs, d’accorder ou refuser des permissions d’utilisation, et de communiquer des informations sur les droits d’usage du contenu.

La solution EdgeSEO de Fasterize offre la possibilité de servir ces fichiers de façon dynamique en fonction du User-Agent détecté, permettant ainsi une gestion plus granulaire de l’accès selon le bot qui interroge le site. Cette approche évite de créer des fichiers statiques multiples et permet d’adapter les règles en temps réel selon l’évolution des pratiques des différents LLMs.

À noter : à ce stade, les retours d’expérience indiquent que les LLMs prennent encore peu en compte ce type de fichier. Google a notamment précisé qu’il ne s’appuyait pas sur le fichier llms.txt, et le comportement des autres modèles peut varier selon les contextes d’usage.

Aujourd’hui, le fichier robots.txt reste le standard le plus largement reconnu pour orienter l’exploration des contenus. Cela dit, comme pour tout mécanisme déclaratif, il ne constitue pas une garantie absolue concernant l’utilisation éventuelle de contenus dans des jeux de données tiers (par exemple via des sources comme Common Crawl).

Mettre en place un fichier llms.txt est aujourd’hui une initiative encore largement exploratoire, sans risque pour votre site. Elle s’inscrit davantage dans une logique de test & learn que dans une stratégie de contrôle pleinement maîtrisée.

À ce stade, il s’agit surtout d’expérimenter, d’observer les éventuels signaux envoyés aux modèles, et de se positionner en anticipation des évolutions futures plutôt que d’attendre un impact immédiat ou garanti.

Le Markdown au service de la densité sémantique

Les agents IA adoptent massivement le Markdown comme format de référence, car il est plus léger, plus lisible et plus rapide à traiter pour les LLMs qu’un HTML parfois trop verbeux. Les développeurs utilisent des outils comme Crawl4AI et Firecrawl pour extraire du contenu web et l’alimenter aux LLMs, et des modèles comme ReaderLM-v2 sont entraînés spécifiquement pour cette transformation.

Le principe consiste donc à convertir le HTML en Markdown à la volée pour les agents IA uniquement. Cette transformation supprime le « bruit » technique (headers, footers, scripts, éléments de navigation) pour présenter au LLM un contenu pur, structuré et moins coûteux en tokens. Sur une page produit Amazon, passer du HTML brut au Markdown ciblé permet ainsi de réduire le volume de tokens de 896 000 à moins de 8 000, soit 99 % d’économie !

La mise en place via EdgeSEO est simple : une règle permet d’identifier le bot IA via son User-Agent et d’adapter dynamiquement le format de réponse en Markdown. L’avantage principal : vous n’avez pas besoin de maintenir deux versions distinctes de vos pages. Vous modifiez votre page HTML classique et elle est automatiquement mise à jour en Markdown pour les bots IA, évitant ainsi tout risque de duplication de contenu ou de désynchronisation.

Injection de FAQ dynamiques : du langage naturel pour les RAG

Le format Question/Réponse est devenu le socle du GEO, car il s’aligne parfaitement avec l’architecture RAG (Retrieval-Augmented Generation) utilisée par les LLMs. Les systèmes RAG récupèrent des chunks d’information pertinents pour alimenter le contexte du modèle, et le format FAQ structure naturellement l’information de manière optimale pour ce processus.

La méthode consiste à injecter des blocs FAQ contextualisés via EdgeSEO sur les pages stratégiques, notamment les catégories à fort trafic. Cette injection dynamique permet d’enrichir le contenu sans alourdir l’expérience utilisateur classique, en adaptant la page selon que le visiteur soit un humain ou un agent IA.

Un point de vigilance à garder à l’esprit : il ne faut pas injecter pour injecter. Chaque FAQ doit répondre à une intention de recherche « Zero-click » réelle, c’est-à-dire fournir une réponse directe et complète à une question que les utilisateurs se posent effectivement. L’objectif n’est surtout pas de gonfler artificiellement le contenu, mais de structurer l’information existante de manière à maximiser les chances d’être cité par les LLMs dans leurs réponses génératives.

Les LLMs ignorent souvent le contenu des iFrames et des widjets JS qui s’exécutent côté client parce que ces derniers créent un contexte isolé du DOM principal. Lorsque des éléments critiques pour l’E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) comme les avis clients Trustpilot sont écrits en JavaScript, ils deviennent invisibles aux « yeux » des agents IA.

La solution ici consiste à récupérer les avis via API et à les injecter directement dans le code source via EdgeSEO avant que la page ne soit servie au crawler. Cette injection côté serveur garantit que le contenu soit présent dans le HTML initial parsé par les LLMs, sans attendre un rendu JavaScript complexe que certains agents IA ne peuvent exécuter.

L’impact direct, c’est un renforcement significatif de l’E-E-A-T aux yeux des algorithmes de recommandation des LLMs. Les avis clients représentent une preuve sociale et une expertise utilisateur que les modèles valorisent fortement dans leurs processus de citation et de recommandation. En rendant ce contenu directement accessible au sein du HTML brut, vous augmentez mécaniquement vos chances d’apparaître dans les réponses génératives.

Webperf & Crawl Budget IA : l’impact de la latence

L’analyse de 2 138 sites web cités par les outils IA met en lumière une corrélation directe entre performance technique et visibilité dans les réponses génératives. Les Core Web Vitals, déjà importantes pour le SEO traditionnel, deviennent doublement critiques pour le GEO étant donné qu’elles affectent la capacité même des LLM-bots à extraire et citer votre contenu.

Les données de l’étude Salt Agency montrent des corrélations parfaitement quantifiables :

- Les sites avec un CLS ≤ 0,1 enregistrent un taux d’inclusion supérieur de 29,8 % dans les résumés génératifs comparés aux sites dépassant ce seuil.

- Les pages affichant un LCP ≤ 2,5 secondes sont 1,47 fois plus susceptibles d’apparaître dans les sorties IA que les pages plus lentes.

- Les crawlers abandonnent carrément 18 % des pages dont le HTML dépasse 1 Mo, soulignant la nécessité d’adopter un balisage épuré.

- Enfin, un TTFB (Time to First Byte) inférieur à 200 ms est en corrélation avec une augmentation de 22 % de la densité de citations, particulièrement lorsqu’il est associé à des stratégies de cache robustes.

Ce point est clé : les LLM-bots ne “naviguent” pas comme des humains. Ils évaluent rapidement la disponibilité, la lisibilité et la rapidité d’accès au HTML. Une latence élevée réduit mécaniquement le nombre de pages explorées et donc la probabilité de citation.

C’est précisément là qu’EdgeSpeed intervient : en réduisant drastiquement le TTFB et en stabilisant les temps de réponse, il augmente le volume de pages réellement exploitables par les bots IA.

L’overhead ajouté par les modifications EdgeSpeed reste marginal (10–15 ms en moyenne) et est largement compensé par l’allègement du HTML et l’optimisation du parsing côté LLM.

Dynamic Rendering vs Cloaking : adapter le format sans tromper

Un site peut afficher d’excellentes Core Web Vitals et pourtant rester invisible des LLMs. Pourquoi ? Parce que son contenu principal dépend d’un JavaScript que les bots IA ne peuvent pas exécuter. Cette réalité technique soulève une question légitime : comment rendre son contenu accessible aux agents IA sans enfreindre les règles des moteurs de recherche ?

Bonne nouvelle : Google fait la distinction. Le géant de Mountain View ne considère pas le dynamic rendering comme du cloaking tant que le contenu servi reste similaire. La différence réside dans l’intention : il ne s’agit pas de cacher du contenu différent, mais de l’adapter en fonction des capacités techniques du client. Une version « data-heavy » pour les bots maximise l’information structurée accessible, tandis qu’une version « UX-heavy » pour les humains privilégie l’expérience visuelle et interactive.

EdgeSEO facilite précisément cette approche en permettant de détecter le User Agent et d’adapter automatiquement le format de livraison du contenu. Concrètement, vous pouvez exposer une version texte enrichie des informations déjà disponibles (par exemple en réinjectant dans le HTML des contenus initialement chargés via widgets embarqués ou API), tout en maintenant une expérience riche pour les utilisateurs humains. Cette approche s’avère particulièrement pertinente dans la mesure où de nombreux LLMs (Claude et certaines versions de Perplexity) ne rendent pas le JavaScript et se comportent davantage comme des scrapers qui lisent le HTML brut que comme des navigateurs complets.

La règle d’or pour rester conforme : le contenu servi aux agents IA doit être une représentation fidèle et complète de l’information présente dans la version utilisateur, simplement optimisée dans sa structure et son format de présentation. Pas de texte caché, pas de mots-clés supplémentaires, pas d’informations différentes, uniquement une adaptation technique pour pallier les limitations des crawlers IA.Point de vigilance : Google ne recommande plus le dynamic rendering comme solution long-terme depuis 2022, privilégiant le Server-Side Rendering (SSR). Cependant, dans le contexte spécifique du GEO, où de nombreux LLM-bots ne peuvent toujours pas exécuter JavaScript en 2026, EdgeSEO est un levier stratégique pour remettre dans le code source les contenus les plus importants afin que ces derniers soient correctement exploités par les bots !