Alors que la frénésie autour des modèles génératifs ne faiblit pas, des promesses toujours plus fortes sont faites et des espoirs toujours plus grands sont placés dans l’intelligence artificielle. Pourtant les preuves d’un phénomène d’emballement médiatique et d’une bulle spéculative sont flagrantes, tandis que les complications s’accumulent à mesure que l’on tente de résoudre tous les problèmes du monde avec ChatGPT. Peut-être est-il temps de se poser la question que l’on aurait dû se poser dès le début, et de s’intéresser à ce que l’on peut faire maintenant, plutôt que de fantasmer sur l’IA généraliste.

La dernière version de la courbe d’adoption des technologies du cabinet Gartner positionne les IA génératives tout en haut du pic des attentes exagérées : Gartner Places Generative AI on the Peak of Inflated Expectations on the 2023 Hype Cycle for Emerging Technologies. Ceci ne me surprend absolument pas dans la mesure où j’ai rarement vu autant de tapage autour d’un sujet. Une frénésie médiatique comparable à une ruée vers l’or dont seuls les vendeurs de pioches profitent réellement pour le moment (le fabricant de puces Nvidia vient ainsi d’annoncer un doublement de son chiffre d’affaires : Nvidia just made $6 billion in pure profit over the AI boom).

Il y a très clairement beaucoup trop d’espoirs et des promesses démesurées autour des modèles génératifs en général et de ChatGPT en particulier : How ChatGPT turned generative AI into an “anything tool”. L’offre est largement supérieure à la demande, un constat que l’on peut aisément constater avec cette flopée de techno-prophètes qui cherchent à nous vendre de la disruption, comme à la grande époque des cryptomonnaies : Les influenceurs IA fleurissent sur les réseaux sociaux.

Pourtant, nous sommes tous conscients des limitations des modèles génératifs qui sont extrêmement prometteurs, mais qui vont se heurter très rapidement à des difficultés juridiques et politiques (entre autres choses) : Greg Rutkowski Was Removed From Stable Diffusion, But AI Artists Brought Him Back et Spain Just Created the First European AI Supervision Agency.

Un miracle technologique auquel tout le monde veut croire, tout de suite !

Le problème actuel est que l’on écoute surtout les avis de ceux qui ont lourdement investi dans l’IA, les grandes sociétés et entrepreneurs qui cherchent à faire une culbute rapide, pas les sceptiques qui sont relayés au banc des ringards, ceux qui n’ont “pas compris l’IA” et n’en perçoivent pas le potentiel. D’où cet effet de miroir déformant et cette bulle spéculative qui prend des proportions inquiétantes : Every start-up is an AI company now, bubble fears are growing.

Depuis le premier article publié sur ce sujet, j’ai adopté une position dubitative sur ce qui nous est présenté comme la plus grande révolution de l’humanité depuis la découverte du feu (Mythes et réalités des IA génératives). Aujourd’hui, je me sens moins seul, car d’autres font preuve de circonspection : No, We Aren’t in an Oppenheimer Moment for AI et Princeton University’s ‘AI Snake Oil’ authors say generative AI hype has ‘spiraled out of control’.

Permettez-moi de clarifier à nouveau mon point de vue pour être certain qu’il ne soit pas mal interprété : les modèles génératifs présentent un potentiel énorme, mais leur adoption à grande échelle ne se fera que sur le long terme (au moins 10 ans) et sera conditionnée par de nombreux facteurs :

- économiques (coûts de déploiement en fonction du prix des licences et de la formation) ;

- environnementaux (consommation d’énergie accrue pour entrainer et faire tourner des modèles qui prennent en compte des centaines de milliards de paramètres) ;

- juridiques (droits d’auteur des contenus servant à l’entrainement et de l’utilisation commerciale des contenus générés) ;

- politiques (régulations, biais et souveraineté) ;

- sociétaux (impacts sur les emplois, désinformation…).

La question que nous sommes en droit de nous poser est donc la suivante : Face à ces nombreuses complications, quel est le ou les problèmes que les IA génératives peuvent de résoudre ? Car dans les faits, de nombreuses promesses sont avancées (concevoir de nouveaux médicaments, faire reculer les inégalités, améliorer la productivité…), mais les cas d’usage concrets et directement applicables sont rares.

Générer plus de contenus ne va pas résoudre le problème d’infobésité (ni celui de la désinformation)

Je vous propose de partir d’une problématique large pour étayer mon argumentation : la compétitivité et la pérennité des entreprises.

Pour résumer de longues explications : les entreprises éprouvent actuellement de grosses difficultés, car elles exploitent des outils des XXe siècle et des méthodes d’encadrement du XIXe siècle. Dans ces conditions, il semble difficile de relever les défis du XXIe siècle (concurrence exacerbée, permacrise, transition écologique…). Sous cet angle là, en quoi les modèles génératifs apportent-ils une réponse concrète et immédiatement bénéfique ?

Il existe effectivement des cas d’usage qui sont directement applicables, j’en conviens, notamment le refactoring de vieilles applications (IBM taps AI to translate COBOL code to Java), le sous-titrage des vidéos (Watch Deepfake Tech Flawlessly Change an Actor’s Spoken Language) ou la traduction (Meta releases an AI model that can transcribe and translate close to 100 languages).

Il me faut également mentionner la prospection, une activité très répétitive qui est, en théorie, facile à automatiser. De nombreux éditeurs sont déjà positionnés sur le créneau et formulent des promesses TRÈS alléchantes (AI for Sales Prospecting – A Complete Guide). Dans l’absolu, ça fonctionne, mais si l’on se place dans la position du prospect qui sera ciblé par cette avalanche de messages automatiques non sollicités (en plus des autres), c’est nettement moins réjouissant (Intelligence artificielle : Nous n’avons pas besoin de plus de contenus, mais de meilleures analyses).

Idem dans le monde de l’édition où les bénéfices attendus de la rédaction automatisée ne sont clairement pas au rendez-vous (‘It almost doubled our workload’: AI is supposed to make jobs easier. These workers disagree), tandis que les inconvénients gagnent en puissance : AI Chatbots Help Web Content Farms Copy Work From Top Publishers.

Le problème est que l’on essaye de forcer l’adoption alors que les entreprises, le grand public et le législateur ne sont pas encore près pour un déploiement à grande échelle des IA génératives, alors que les escrocs eux le sont déjà !

Au vu des enjeux et de la technicité du sujet, il est tout à fait logique qu’il y ait un temps d’adaptation pour que le marché puissent se stabiliser, et notamment un équilibrage entre l’offre et la demande : The world isn’t ready for the nexte decade of AI. Une nécessaire période de transition que l’on ne sait pas encore évaluer, mais pendant ce temps, les difficultés et ennuis s’accumulent.

Ainsi, la réalité que personne n’ose aborder est que la situation devra empirer avant qu’elle ne s’améliore. Comprenez par là que nous devrons d’abord subir les désagréments de tous les usages détournés et malveillants avant de pouvoir bénéficier des modèles génératifs dans de bonnes conditions (légales, durables, soutenables…).

D’ici là, nous devons nous préparer à de nombreux casses-têtes et des décisions politiques précipitées :

Ceci nous amène à une seconde question de fond : les entreprises et les salariés (cols blancs) sont-ils prêts pour adopter les IA génératives ? Pas tant que ça…

Un gigantesque potentiel… déjà identifié il y a 5 ans

Les experts de McKinsey sont formels : les IA génératives vont permettre d’automatiser 60 à 70% des tâches des travailleurs du savoir (les fameux cols blancs), mais ils ne précisent pas qui, quand, ni comment, ils se content d’un très approximatif “The era of generative AI is just beginning” (cf. The economic potential of generative AI: The next productivity frontier).

Bon d’accord, j’avoue que ce n’est pas très fair play de ma part, car le rapport est bien détaillé et identifie notamment cinq domaines dans lesquels les modèles génératifs vont avoir un réel impact : le développement logiciel, les services à la clientèle, le marketing, la vente et la R&D.

Ceci étant dit, ce rapport sonne comme une prophétie autoréalisatrice qui me donne une impression de déjà vu. Je vous rappelle ainsi que des prédictions similaires avaient déjà été formulées il y a 5 ou 6 ans à l’époque de la bulle médiatique autour du machine learning. Et les mêmes limites de l’apprentissage machine avaient déjà été identifiées : De l’importance des données (et des humains) pour le machine learning (publié en 2017).

Vous conviendrez que l’impact immédiat et brutal que l’on avait prédit à l’époque tarde à se faire ressentir…

De nombreux prérequis pour un épouvantail culturel

S’il est encore trop tôt pour décider de qui à raison ou tort, j’enrage, car en paralèle de ces rapports à priori sérieux, les médias et de nombreux pseudo-experts font toujours l’amalgame entre un modèle d’apprentissage profond (les transformeurs), un concept (l’intelligence artificielle) et un fantasme (les IA généralistes). Cette confusion participe à un brouhaha médiatique où se côtoient promesses délirantes, prévisions farfelues et arguments nébuleux, sans jamais aborder la question de l’utilité. De tout ceci, il ne peut rien ressortir de bon, comme ce fut le cas pour le métavers, un concept protéiforme que l’on nous a servi jusqu’à écœurement, provoquant une réaction logique de saturation et de rejet.

Une réaction de rejet que l’on commence déjà à ressentir sous la forme d’une méfiance vis-à-vis de cette “technologie” révolutionnaire : What European Consumers Think About AI. La faute en partie aux fausses idées propagées dans les fictions (ex : le dernier Mission Impossible qui passe au cinéma ou Agent Stone disponible depuis peu sur Netflix : Netflix’s Movie Shows Us What A “Real World” Quantum Computer With Predictive AI Capabilities Has The Potential To Do).

// Interlude rationnel

Au cas où vous poseriez la question : non, ce n’est pas comme ça que fonctionnent les ordinateurs quantiques :

- Ils nécessitent des conditions d’exploitation extrêmes (notamment un refroidissement à -273°) ;

- Les qbits ne délivrent leur potentiel qu’avec des opérations arithmétiques bien particulières (puisqu’ils ne sont pas binaires), nécessitant un nouveau paradigme de programmation ;

- Plus les calculs probabilistes intègrent de paramètres (comme c’est le cas dans ces films) et moins ils sont fiables.

// Fin de l’interlude rationnel

La faute également à tous ces analystes, consultants et conférenciers peu scrupuleux qui profitent de l’engouement pour alimenter la frénésie médiatique et tenter d’en bénéficier. J’en profite pour rappeler que je n’ai jamais versé dans la facilité et que j’ai été un des seuls à temporiser et à prendre du recul sur ce sujet : Quels scénarios d’adoption pour les IA génératives ?

Sinon, pour revenir à notre question : Oui, les modèles génératifs seront forcément bénéfiques aux cols blancs, mais on ne sait pas dans quels délais. Oui, ils ont le potentiel de radicalement transformer l’environnement et les habitudes de travail (Quel modèle de collaboration à l’heure des IA génératives ?), mais sous certaines conditions. Pour faire une comparaison hasardeuse : on nous avait également promis une explosion de la productivité il y a quelques années grâce aux big data. Au final, les gains de productivité sont bien réels, mais compliqués à mettre en oeuvre à grande échelle, car ils nécessitent des données de qualité et de nouvelles façons de travailler (processus, outils…). De là à dire que les modèles génératifs sont pour le moment immatures, il n’y a qu’un pas, franchi d’ailleurs par cet auteur : AI Isn’t Good Enough.

Pour pouvoir automatiser la majeure partie des tâches des travailleurs du savoir, il va d’abord falloir les répertorier et les modéliser, de même que structurer les données et connaissances éparpillées dans les emails et fichiers bureautiques. Une tâche titanesque qu’aucune entreprise ou éditeur n’est parvenu à compléter, préférant miser sur des solutions de contournement (Slack, Zoom, Teams…).

Au vu des contenus que les modèles génératifs sont capables de produire, vous pourriez croire que c’est justement à ça qu’ils vont servir, mais ça serait oublier que les capacités des IA reposent sur des calculs statistiques engendrant des hallucinations qui ne sont pas tolérables dans le milieu professionnel : Are GenAI Hallucinations Fixable? Maybe Not. Autant un designer peut se permettre de reformuler 50 fois sa commande textuelle quand il expérimente des modèles génératifs comme MidJourney ou StableDiffusion, autant j’imagine mal un collaborateur lambda reformuler 50 fois sa demande de génération d’email ou de compte-rendu de réunion (ce n’est pas ce que j’appelle un gain de productivité).

Voilà pourquoi il est tout à fait juste de dire que les modèles génératifs sont trop immatures pour envisager un déploiement massif à court terme, surtout pour les professions intellectuelles et les cols blancs. En revanche, sous l’angle de l’automatisation, il y a potentiellement de très bonnes choses à envisager pour les tâches manuelles.

Une réindustrialisation de la production en France (à minima en Europe) grâce à l’automatisation

L’automatisation des chaines de production a commencé au début des années 1960 dans les usines de General Motors. Des progrès spectaculaires ont depuis été réalisés en matière de robotique, mais les automates de dernière génération ne sont pas forcément rentables pour toutes les unités de production. L’équation économique fait que hommes et machines se répartissent le travail : de nombreuses opérations sont encore réalisées à la main car c’est plus rapide (monis couteux). Il suffit de trainer sur une chaine YouTube comme ProcessX pour se rendre compte que se côtoient dans les usines des machines à commandes numériques dernier cris avec des séniors équipés de tournevis et cales en bois.

Le problème est que l’implémentation d’un robot sur une ligne de production active passe par une longue phase d’étude, d’installation, de paramétrage et d’optimisation. La clé de l’automatisation réside dans une phase d’apprentissage des gestes, d’alignement (règles de sécurité) et de renforcement (diminution du nombre d’erreurs) plus courte. Ça ne vous rappelle rien ? Les fameux transformeurs se révèlent de façon surprenante tout à fait adaptés à la reconnaissance visuelle des gestes et objets, donc à l’automatisation.

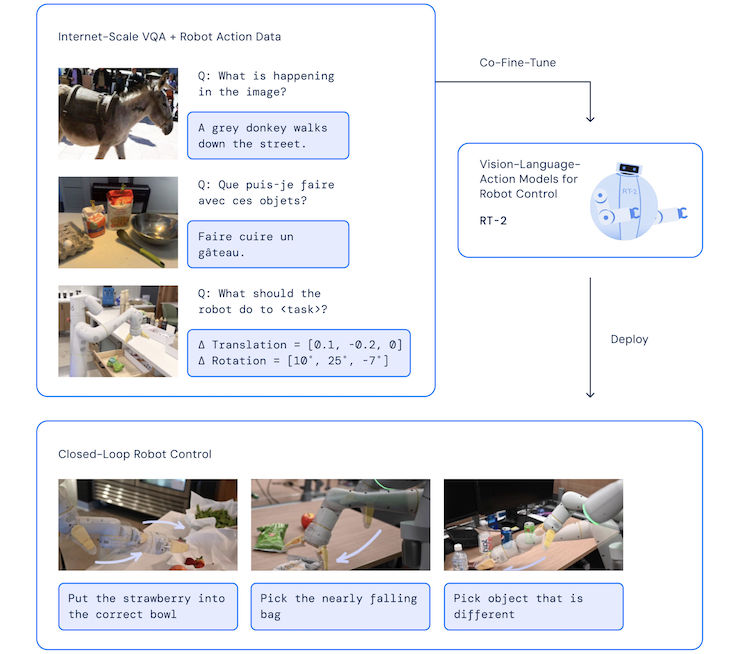

Cet été, une percée spectaculaire a été réalisée par les équipes de Google avec la nouvelle version de son modèle Vision Langage Action (VLA) avec les Robotic Transformers 2 (RT-2). Un modèle permettant à des automates de faire de la reconnaissance visuelle (formes), de la compréhension (fonctions) et du raisonnement (prise de décision) : RT-2: New model translates vision and language into action.

D’après mes sources, Il y a 3,5 M de robots en activité dans le monde, ce qui est très peu comparé au nombre de travailleurs manuels (plus d’1 milliard d’après le WEF). Les modèles VLA permettraient non pas d’améliorer les performances des robots actuels, mais de rendre les automates plus versatiles, de les utiliser pour des tâches variées afin de maximiser leur rentabilité.

En résumé : de démocratiser l’utilisation de la robotique grâce à des automates plus limités, mais plus simples à utiliser grâce à la commande vocale et l’apprentissage automatique.

Ici, le robot n’en est pas réellement un, car il ne travaille pas en autonomie en reproduisant inlassablement les mêmes gestes, mais il attend les instructions de son binôme humain qui endosse le rôle de superviseur. Voilà pourquoi on ne parle pas de robot, mais de cobot : Google’s RT-2 AI model brings us one step closer to WALL-E.

Nous pouvons ainsi tout à fait envisager une configuration où chaque établi serait équipé d’un bras polyvalent comme celui présenté ci-dessous pour pouvoir assister les ouvriers dans leurs tâches, une forme très concrète de cobotique avec la possibilité de travailler “main dans la pince” avec les cobots (je n’assume pas cette blague très douteuse trouvée ici : Qu’est-ce que la cobotique ?).

(Source : TrinityRobotics, une initiative financée par l’UE 🇪🇺)

Cela fait 5 ans que la France a lancé son Plan de réindustrialisation. Un Plan qui ne pourra être exécuté que si les unités de production industrielle ré-implantées en France parviennent à trouver suffisamment de main-d’oeuvre. Or, comme vous devez déjà le savoir, il y a une terrible tension sur le marché du travail, car on manque de travailleurs manuels. Ces avancées en matière de reconnaissance visuelle et d’apprentissage automatique seraient justement l’occasion non pas de re-créer un tissu industriel “à l’ancienne”, mais d’en créer un nouveau, reposant sur des pratiques modernes comme la cobotique.

Je ne suis ni sociologue, ni économiste, mais je pense que nous avons ici un cas d’usage tout à fait viable dans la mesure où tout le monde y gagne : création d’emplois (individus), rapatriement des capacités de production (entreprises), raccourcissement des chaines d’approvisionnement (planète) et complétion du plan quinquennal (Gouvernement).

Une perspective nettement plus intéressante qu’Arnold Schwarzenegger en train de chanter du Witney Houston, non ?