Montrer Cacher le sommaire

- Préambule sur l’A/B Testing

- A/B Testing : une méthode d’expérimentation centenaire

- Comment fait-on un A/B Test ?

- 1 / La plus grande attention, tu accorderas à l’échantillon de ton A/B test

- La méthode pour définir la taille d’échantillon idéale pour ses tests

- L’importance de la randomisation pour la validité d’un A/B test

- 2 / A une seul métrique « reine », tu t’en tiendras pour évaluer les résultats de ton A/B test

- Résistez à la tentation des « corrélations fallacieuses » : tenez vous en à un ou deux KPIs

- 3 / Avec bon sens, tu formaliseras l’hypothèse de ton A/B test

- Ne vous trompez pas de question

- Le framework pour une bonne hypothèse : Si… Alors… Parce que…

- Être clair sur les « degrés de libertés » testés pour déterminer s’il vous faut un A/B test ou un test multivarié (MVT)

- 4 / Avec méthode (et audace), tu cadreras ton A/B test

- Choisissez les bonnes pages à tester avec Google Analytics

- Utilisez les heatmap pour comprendre quels éléments vous devriez A/B tester

- Soyez audacieux dans vos changements (surtout si vous êtes un petit site)

- 5 / Lors ton A/B test, tu feras preuve de rigueur et de patience

- Pour être certain que les données collectées sont bonnes, envisagez de faire un test A/A

- Être patient et accepter de perdre souvent…

- 6 / A nouveau, tu t’intéresseras de près à l’échantillon des populations ayant pris part à ton test

- Décortiquez dans Google Analytics « qui » a été exposé à votre test pour vérifier l’homogénéité des populations

- Analysez des données basées sur les utilisateurs pour intégrer les comportements dans le temps

- Analyser en détail les groupes « test » et « contrôle » pour déterminer « pour qui » une version est plus efficace

- 7 / Avec jugement, tu interpréteras les résultats de ton A/B Test

- Interprétez correctement les résultats de vos A/B tests (notamment en ce qui concerne la significativité statistique)

- Intégrer le coût d’implémentation dans l’analyse des conclusions d’A/B tests

- Complétez vos A/B tests avec d’autres données

- 8 / Continue de tester, même quand tu crois avoir trouver la variante gagnante

- Optimum local & Optimum global : avons-nous réellement atteint le meilleur résultat possible ?

- Osez refaire vos A/B tests de temps à autres

- Evitez néanmoins de tomber dans le piège de « sur tester » votre hypothèse

- 9 / Un vrai processus, tu structureras autour de l’A/B testing

- Documentez les résultats de vos A/B Tests

- Définissez un modèle organisationnel, dédié à l’A/B testing

- Conclusion

- FAQ A/B Test

- Qui a inventé l’A/B test ?

- Quel est l’objectif d’un test A/B ?

- Comment faire un test A/B ?

- Quel est l’avantage principal de l’A/B testing ?

Cadrage de vos A/B tests : Téléchargez le template gratuit

En complément de cet article, vous pouvez télécharger gratuitement mon template pour cadrer vos A/B tests comme un professionnel !

Il vous suffit simplement de vous abonner à ma newsletter.

Aujourd’hui, Microsoft et plusieurs autres grandes entreprises, dont Amazon, Booking.com, Facebook et Google, mènent chacune plus de 10 000 A/B tests par an, sur des millions d’utilisateurs. Même les entreprises les plus traditionnelles, telles que Walmart, Hertz et Singapore Airlines, les exploitent régulièrement elles aussi.

Depuis l’avènement du marketing digital, l’A/B testing s’est démocratisé. Logique, car les outils d’A/B testing facilitent grandement la mise en place de ces expérimentations. Ces dernières permettent aux marketeurs de prendre des décisions éclairées, validées par des expériences scientifiques, « à facteurs contrôlés ».

Tout d’abord, accordons nous quelques lignes pour redéfinir ce qu’est l’A/B testing. Puis, nous énumérerons les 8 commandements pour des A/B tests réussis.

Cadrage de vos A/B tests : Téléchargez le template gratuit

En complément de cet article, vous pouvez télécharger gratuitement mon template pour cadrer vos A/B tests comme un professionnel !

Il vous suffit simplement de vous abonner à ma newsletter.

Préambule sur l’A/B Testing

A/B Testing : une méthode d’expérimentation centenaire

Quels que soient les aspects opérationnels les plus importants pour votre entreprise, tels que les ventes, les revisites, les taux de clics / de conversion ou le temps que les utilisateurs passent sur vos pages, vous pouvez utiliser les A/B tests pour déterminer comment optimiser vos résultats.

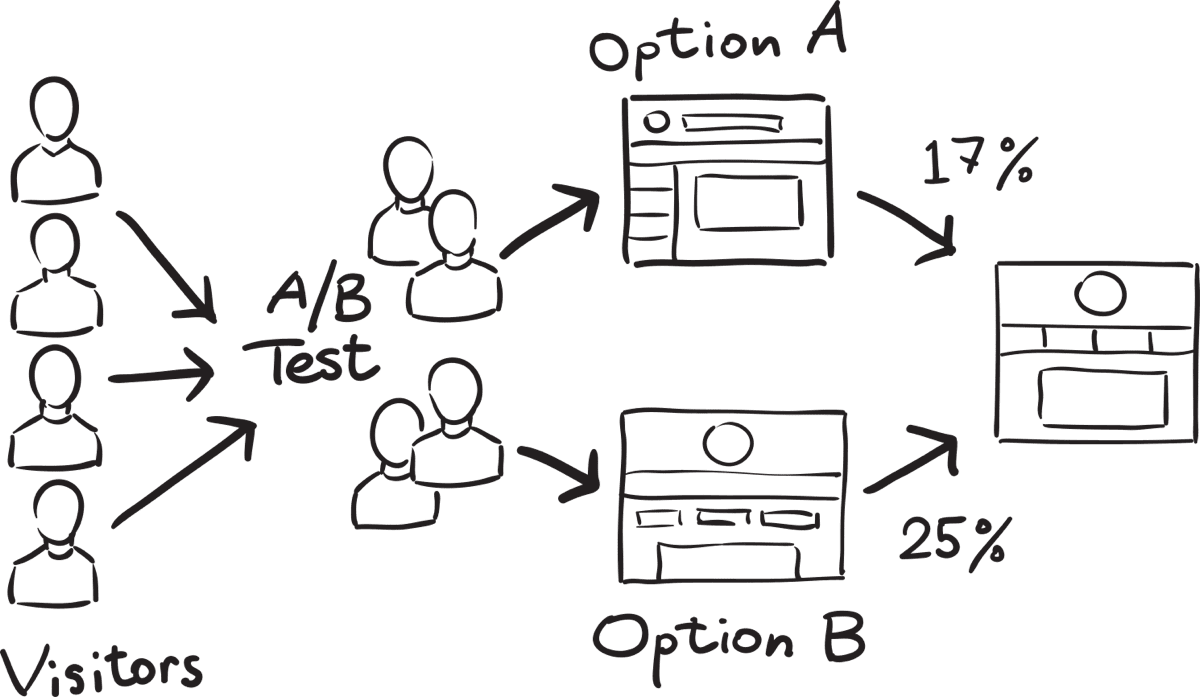

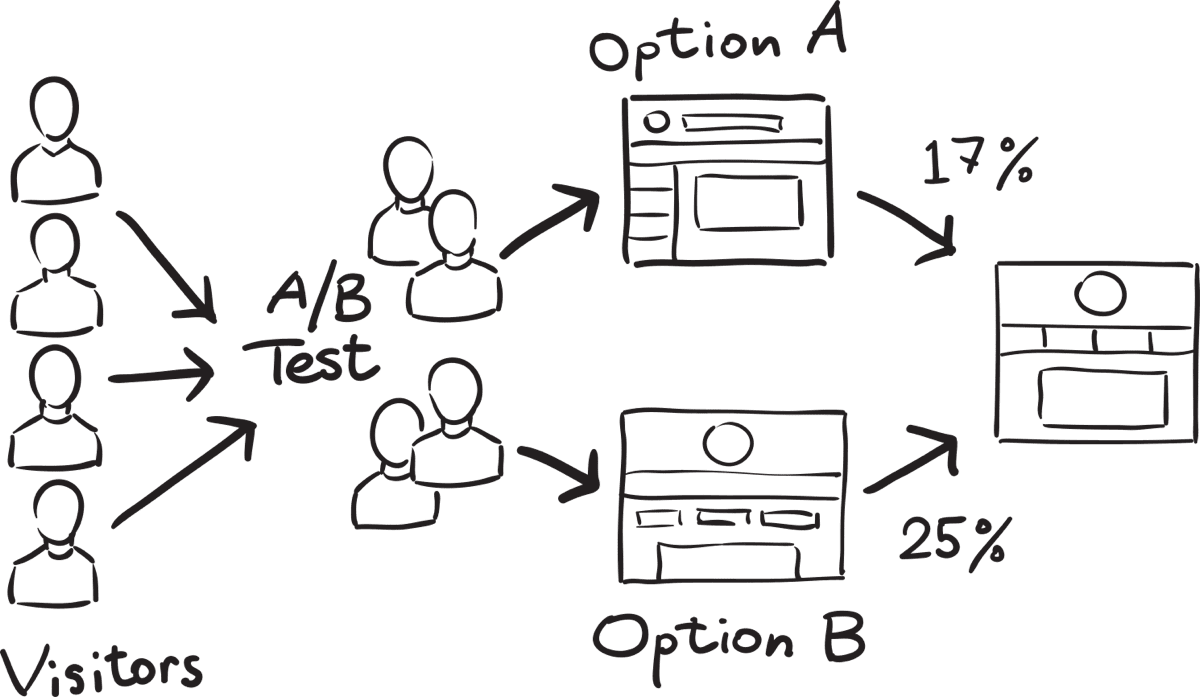

Les tests A/B, dans leur forme la plus élémentaire, sont un moyen de comparer deux versions de quelque chose pour déterminer laquelle fonctionne le mieux. Bien qu’elle soit le plus souvent associée au marketing digital, c’est en réalité une méthode qui a presque 100 ans.

Comment fait-on un A/B Test ?

Les principes mathématiques derrière les tests n’ont pas changé. Ce sont les mêmes concepts de base, mais maintenant qu’on applique au marketing digital :

- Vous démarrez un test A/B en décidant ce que vous voulez tester, en faisant une hypothèse (par exemple : la taille d’un bouton sur votre landing page – plus gros, il sera plus simple de cliquer dessus).

- Ensuite, vous devez savoir comment vous évaluerez ses performances (par exemple : le taux de clic sur le bouton en question).

- Pour exécuter le test, vous montrez à deux groupes d’utilisateurs (attribués au hasard lorsqu’ils visitent le site) les différentes versions (où la seule chose différente est ce que vous voulez tester).

- A la fin, vous déterminez la version qui a le plus influencé votre métrique de réussite.

Bien que simple à mettre en oeuvre, l’exercice de l’A/B test peut s’avérer plus sournois qu’il n’y parait. Pour ne pas tomber dans les pièges classiques, et vous laissez induire en erreurs, respectez les commandements qui suivent.

1 / La plus grande attention, tu accorderas à l’échantillon de ton A/B test

La méthode pour définir la taille d’échantillon idéale pour ses tests

Le test A/B est une méthode quantitative. Plus la taille de votre échantillon test est petite, plus il devient difficile d’obtenir des mesures fiables et précises. Ainsi, choisir le bon nombre d’utilisateurs pour un A/B test est crucial. Si vous n’effectuez pas de tests sur suffisamment d’utilisateurs, vos résultats seront biaisés, ce qui les rendra forcément moins utiles.

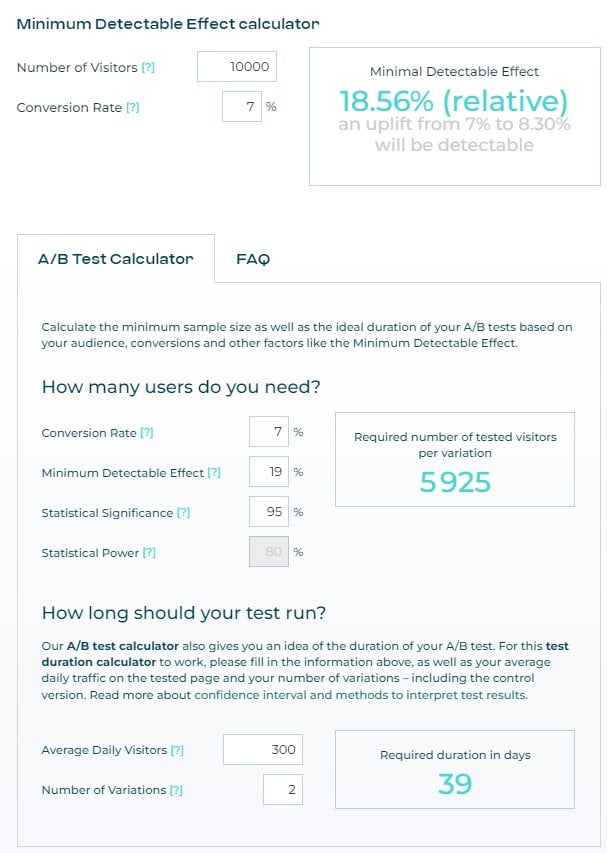

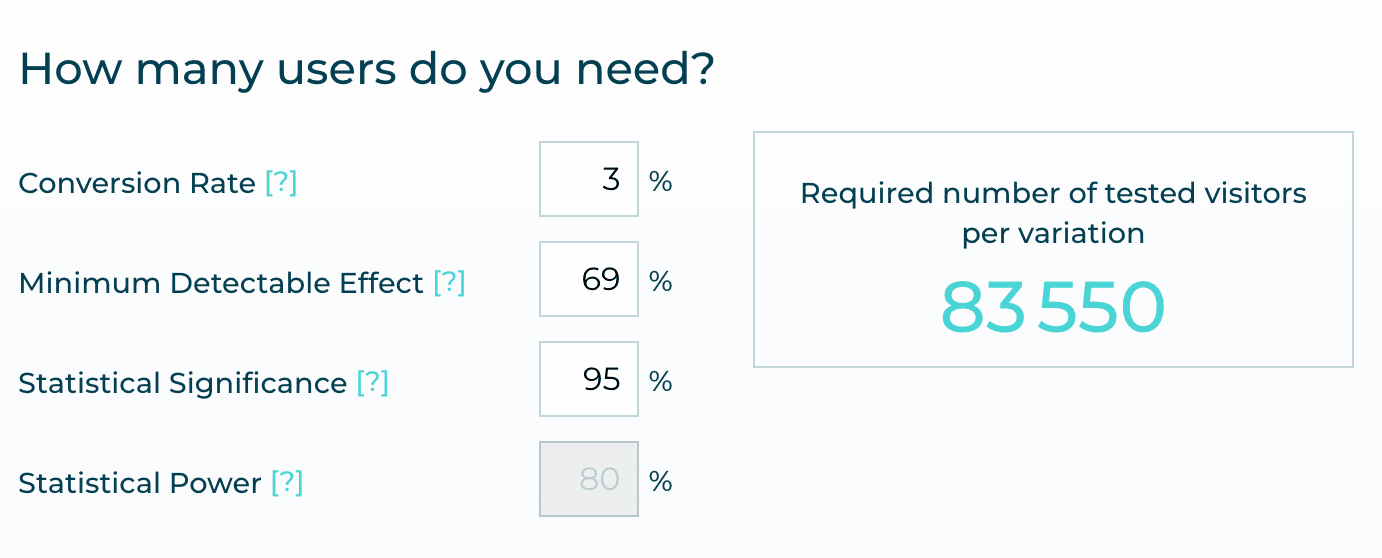

Pour déterminer la bonne taille d’échantillon :

- Cela commence par connaître votre taux de conversion de base.

- Puis, vous devez définir l’effet minimum détectable, c’est à dire le plus petit effet que vous estimez nécessaire de détecter dans l’évaluation d’impact de votre version testée. Vous pouvez le calculer en connaissant le nombre de visiteurs que vous recevez, et votre taux de conversion de base.

- Vous devez enfin définir le niveau statistiquement significatif, qui indique la probabilité que la différence de conversion entre une variation et la version existante ne soit pas due au hasard. Généralement, 95 % est une norme acceptée pour la signification statistique.

Une fois que vous avez établi ces chiffres, utilisez un calculateur qui vous aidera à déterminer la bonne taille d’échantillon pour votre test (comme celui de AB Tasty par exemple). Il vous suffira alors de diviser cette dernière information par le trafic hebdomadaire que vous comptez envoyer sur vos variations pour en déduire le nombre de semaines que devrait prendre votre expérience.

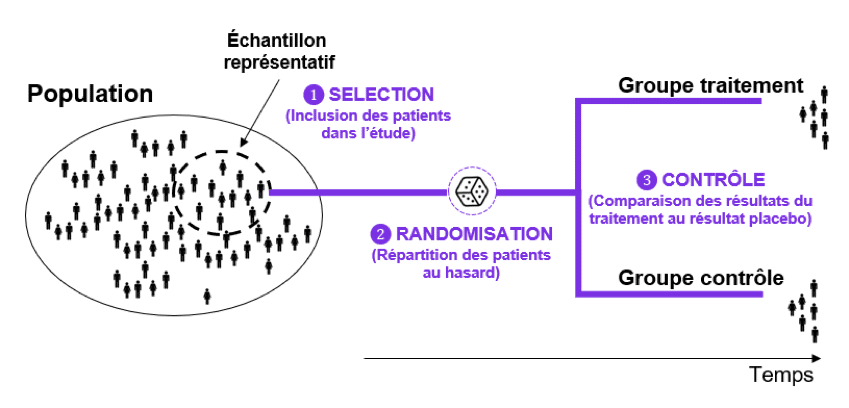

L’importance de la randomisation pour la validité d’un A/B test

Dans la vraie vie, il y a beaucoup de choses qui peuvent influencer les agissements d’une personne. Par exemple, il se peut que les utilisateurs d’un appareil mobile soient plus susceptibles de cliquer sur un bouton d’une certaine taille, tandis que les visiteurs desktop sont plus attirés par une taille différente.

C’est là que la randomisation est essentielle : en déterminant de manière aléatoire quels utilisateurs appartiennent à quel groupe, vous minimisez les chances que d’autres facteurs biaisent vos résultats (comme le type d’appareil utilisé). C’est pourquoi vous ne devriez jamais choisir les populations test en fonction de préjugés existants.

2 / A une seul métrique « reine », tu t’en tiendras pour évaluer les résultats de ton A/B test

Résistez à la tentation des « corrélations fallacieuses » : tenez vous en à un ou deux KPIs

Une erreur commune consiste à regarder trop de métriques. Ce n’est pas parce que le logiciel d’A/B testing vous permet de consulter tout un panel de métriques que vous devriez créer « une histoire » avec tous les chiffres que vous avez à disposition.

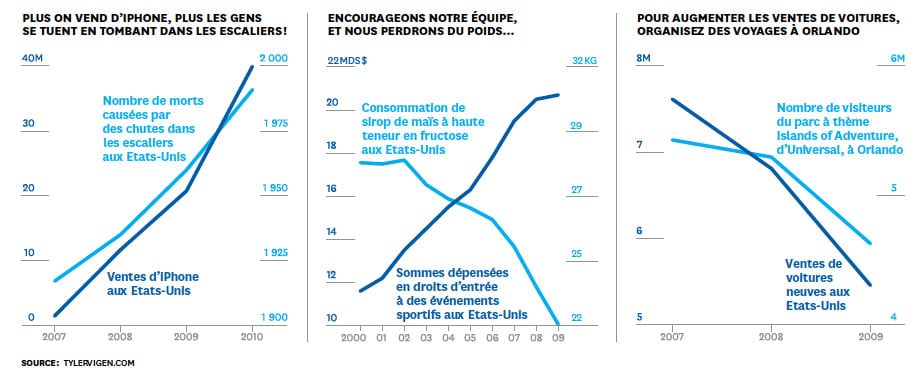

Le problème est que si vous examinez un grand nombre de mesures en même temps, vous risquez de créer ce que les statisticiens appellent des «corrélations fallacieuses». Ce sont des phénomènes qui, bien qu’ils évoluent de la même manière, n’ont aucun lien de cause à effet.

Un test bien conçu est un test pour lequel on décide à l’avance des mesures que l’on va examiner. Cela peut-être un indicateur ou deux… Mais plus vous voudrez prendre en compte des métriques différentes, plus vous risquez de voir des fluctuations aléatoires.

Prendre en compte trop de métriques vous détourne aussi de votre vrai question (est-ce que le taux de conversion à augmenter?) et vous pousse dans des analyses exploratoires, parfois totalement insignifiantes.

De l’art de bien choisir « la » métrique à évaluer dans un test A/B

Dans la plupart des A/B tests, les marketeurs prennent une métrique « reine » simple (comme le taux de conversion), qui mesure l’action qu’ils attendent que l’audience entreprenne.

Vu sous cet angle, celui d’un e-commerce lambda, choisir la bonne métrique parait simple. Mais il est difficile en réalité de déterminer quelles mesures à court terme sont les meilleurs prédicteurs des résultats à long terme. De nombreuses entreprises peuvent tomber dans le piège…

Prenez Microsoft Bing :

- leur objectif à long terme est d’augmenter sa part de requêtes sur les moteurs de recherche et ses revenus publicitaires.

- Hors un de ses tests à prouver que diminuer la pertinence des résultats de recherche incite les utilisateurs à formuler plus de requêtes (augmentant ainsi la part des requêtes) et à cliquer davantage sur les annonces (augmentant ainsi les revenus).

- Évidemment, de tels gains ne seraient que de courte durée, car les gens finiraient par délaisser Bing comme moteurs de recherche, car ses résultats seraient toujours moins pertinents que ceux des concurrents.

C’est avec ce type d’exemple qu’on comprend que définir « la » bonne métrique pour mesurer le succès peut être un exercice périlleux.

Avant de proposer n’importe quel KPI, le marketeur doit d’abord penser au relations de causes à effets que cela pourrait produire, au delà de l’expérience qui est menée. Et c’est avec la pratique que les équipes acquièrent non seulement une expérience précieuse sur les métriques qui fonctionnent le mieux pour certains types de tests, mais aussi qu’ils développent de nouvelles métriques, qui reflètent mieux les enjeux uniques de l’entreprise.

3 / Avec bon sens, tu formaliseras l’hypothèse de ton A/B test

Ne vous trompez pas de question

Le test AB, sans réelle stratégie de persuasion, est voué à l’échec

Ne vous méprenez pas. L’A/B testing n’est pas un remède miracle aux échecs commerciaux cuisants… Ce n’est pas parce que le fond rouge converti +36% de plus que le fond bleu que, soudainement, les clients vont se bousculer au portillon.

L’expérience utilisateur ne fait pas tout. Les internautes arrivent à des décisions similaires, avec des processus psychologiques différents, des attentes & des objectifs de visite qui se distinguent. Etablir le bon persona, et la bonne stratégie de persuasion est le point de départ et la clé de voûte d’un site performant.

Il vous appartient donc de travailler en premier lieu cet aspect avant de penser à savoir si le rouge est mieux que le bleu. Car quelque soit la conclusion de votre test, vous ne remédierez pas « aux causes profondes » de votre contre-performance.

Le framework pour une bonne hypothèse : Si… Alors… Parce que…

Une hypothèse complète comporte trois parties. L’énoncé est le suivant : « Si , alors , parce que. » (If, Then, Because en version originale). La variable, le résultat attendu et le rationnel sont les trois éléments de votre hypothèse qui doivent être correctement documentés avant de lancer votre A/B test.

Examinons chaque élément plus en détail et passons en revue un exemple :

SI

« La variable »

On parle ici de l’élément de votre site que vous souhaitez tester. Essayez d’isoler une seule variable pour un test A/B/n, ou quelques variables pour un test multivarié.

Exemple : Si le bouton d’action sur ma page est plus gros…

ALORS

« Le résultat »

C’est l’effet que vous comptez produire avec votre changement. Il peut s’agir d’un plus grand nombre de conversions, de clics sur un lien en particulier, de visionnages d’une vidéo… Bref, c’est votre métrique « reine ». Pensez à relever au départ la référence à laquelle vous allez vous comparer (ex : quel est votre taux de conversion actuel?). Vous serez alors plus à même de définir quelle augmentation raisonnable vous pourrez espérer.

Exemple : …Alors le taux de conversion sur ma landing page passera de 3% à 3.2%…

PARCE QUE

« Le rationel »

Grâce à vos analyses quantitatives & qualitatives préalables, vous pourrez avoir une intuition de la relation de cause à effet que vous voulez tester. Cette intuition peut aussi bien venir de l’analyse de vos statistiques, des heatmaps, voire même d’entretiens avec les clients, de sondages réalisés sur vos prospects, etc.

Exemple : …Parce que la moitié de nos utilisateurs tests n’ont pas remarqué immédiatement le bouton d’action lors de leur navigation.

En respectant cette trame, vous êtes assuré d’établir une hypothèse solide, 100% du temps.

Être clair sur les « degrés de libertés » testés pour déterminer s’il vous faut un A/B test ou un test multivarié (MVT)

Imaginons le formulaire de contact de votre site web. Vous réalisez un A/B test pour déterminer s’il est plus efficace que les internautes valident leurs informations avec un petit bouton rouge, ou un gros bouton bleu.

Le problème, c’est que ce simple A/B test ne peut que vous donner une vision « générale » de la performance. Pour déterminer fidèlement les causes de la du succès, il conviendrait d’utiliser 2 tests:

- Un A/B test pour la couleur.

- Un A/B test pour la taille du bouton.

Il existe donc différents « degré de liberté ». Comme dans notre exemple la couleur, la taille du bouton. On aurait pu ajouter également le libellé du bouton, qui serait encore un autre « degré de liberté ».

Le problème est que pour réaliser une analyse fine -donc un test AB découpé en étapes successives de sous-test AB- il va vous falloir un nombre de visiteurs et une durée d’expérimentation plus importants pour explorer tous vos « degrés de liberté ».

De plus, vous n’êtes pas certain que les variables peuvent vraiment être considérées comme des éléments isolés. Ce sont des facteurs qui interagissent entre eux, et créent des synergies. C’est aussi cela qui va impacter votre taux de conversion, mais vous n’aurez pas réellement de moyens pour mesurer cette « inter-contribution ».

Si vous devez tester plusieurs degrés de liberté dans le même test, le mieux est d’exécuter des tests multivariés (tests MVT), et non de simples A/B tests. Grâce à eux, vous pouvez mesurer la contribution indépendante de chaque degré de liberté.

Cadrage de vos A/B tests : Téléchargez le template gratuit

En complément de cet article, vous pouvez télécharger gratuitement mon template pour cadrer vos A/B tests comme un professionnel !

Il vous suffit simplement de vous abonner à ma newsletter.

4 / Avec méthode (et audace), tu cadreras ton A/B test

Choisissez les bonnes pages à tester avec Google Analytics

Pour que votre A/B test soit un succès, vous devez tester des pages :

- sur lesquelles l’internaute peut réaliser l’action que vous attendez de lui,

- qui reçoit un trafic « important » pour accélérer la durée du test, et arriver plus rapidement à des conclusions statistiquement significatives.

Pour déterminer quelle pages vous devriez tester, pensez à vérifier les pages qui sont les plus visités et qui « convertissent » le plus. Il est facile d’obtenir ces ces informations à partir de Google Analytics. Allez dans Comportement > Contenu du site > Toutes les pages.

Utilisez les heatmap pour comprendre quels éléments vous devriez A/B tester

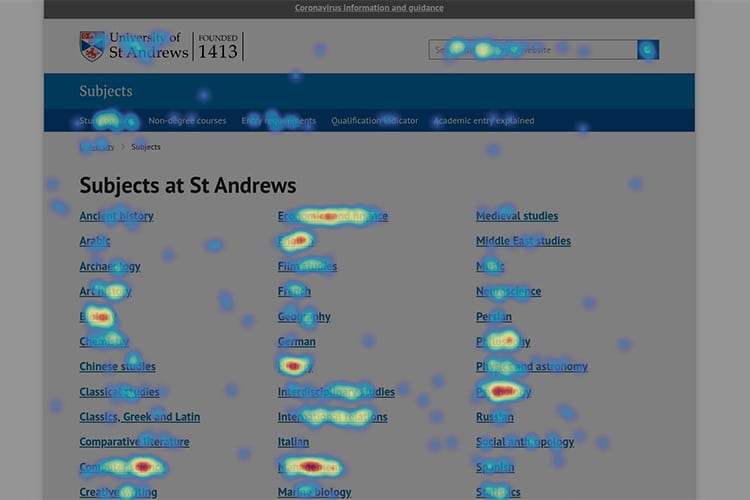

Une fois que vous avez identifiées les URLs qui seront les meilleures candidates pour votre A/B test, je vous invite à préciser quel type de contenu sur la page attire particulièrement l’attention des utilisateurs.

Si vous avez un outil de heatmap implémenté sur votre site (comme Hotjar par exemple), vous pourrez rapidement comprendre quelles zones de la page reçoivent le plus d’interactions et celles que les utilisateurs ignorent. Vous serez alors en mesure d‘identifier les zones « chaudes et froides » que vous pouvez challenger avec votre A/B test.

Soyez audacieux dans vos changements (surtout si vous êtes un petit site)

Les gros sites ont pour habitude de faire « des petits changements », qui rapportent gros. Etant donné leur volumétrie de visiteurs, la plupart des progrès sont réalisés en mettant en œuvre des centaines d’améliorations mineures. Les expériences d’Amazon, par exemple, ont révélé que déplacer certaines offres Prime de la page d’accueil à la page panier augmentait leurs bénéfices de dizaines de millions de dollars par an !

Inspirés par ces succès, de nombreux marketeurs effectuent de « petits » A/B tests sur leurs propres sites, avec des petits volumes. Par exemple, ils décident de tester d’abord la taille d’un bouton (grande ou petite), puis testent la couleur (bleu contre rouge), puis testent la police de caractères (Times contre Arial). Leurs intentions sont bonnes : ils veulent respecter la règle : « un changement à la fois ». Et c’est en effet ce qu’il faut faire, en théorie, comme nous l’avons vu dans le paragraphe sur les degrés de liberté.

Mais, pour un plus petit site, est-ce que faire des A/B tests où chaque élément est successivement testé individuellement est vraiment la bonne option ? Cela peut prendre des décennies pour tester de manière scientifiquement valide les centaines d’éléments différents qui peuvent influencer la performance. Or, souvent, ces petits sites sont plus intéressés par le résultat business que par la « validité scientifique impeccable » de leurs tests.

Si après tout, vous faites 10 changements sur une page et que votre chiffre d’affaires augmente de 30%, vous vous fichez éperdument de connaitre exactement ce que chaque changement vous a rapporté. D’autant que vous testez ici un élément soumis aux comportements des utilisateurs, et dont les motivations profondes peuvent être difficiles à déterminer.

Donc la règle de seulement tester « une chose après l’autre » est un luxe que seuls les gros sites peuvent se payer. Si vous n’avez pas beaucoup de trafic, vous allez devoir être un peu plus pragmatique pour observer un résultat business plus rapide. Ceci dit, si un élément précis fait débat au sein de votre équipe, il est tout à fait approprié de réaliser un A/B test avec ce seul élément comme degré de liberté.

5 / Lors ton A/B test, tu feras preuve de rigueur et de patience

Pour être certain que les données collectées sont bonnes, envisagez de faire un test A/A

Peu importe la qualité de vos critères d’évaluation, si les gens ne font pas confiance aux résultats de vos tests, cela ne sert à rien. Obtenir des chiffres est facile, mais obtenir des chiffres fiables l’est moins. Or, vous voulez baser vos décisions sur des données de qualité. Pour y parvenir, il est nécessaire de consacrer du temps et des ressources pour vous assurer que votre A/B test sera bien valide.

Une méthode efficace consiste à exécuter des tests A/A, c’est-à-dire à tester quelque chose par rapport à lui-même pour s’assurer qu’environ 95 % du temps, le système n’identifie aucune différence statistiquement significative (sinon, c’est que la manière dont votre A/B testing fait son split de visiteurs et/ou collecte ses données est louche). Cette approche simple a aidé des grands de la Tech, comme Microsoft, à identifier des centaines d’A/B tests non valides.

Être patient et accepter de perdre souvent…

Non seulement vous devez être stricts dans vos interprétations des résultats, mais aussi être conscients des effets contextuels de votre test A/B : le timing, la météo, le contexte économique, etc. peuvent affecter la nature de votre audience. Même si après deux jours d’A/B testing vos résultats sont significatifs, ils peuvent ne pas l’être lors d’une autre semaine de l’année.

Trop de marketeurs stoppent leurs tests trop vite. Étant donné que la plupart des logiciels d’A/B testing permettent de visualiser les résultats en temps réel, les responsables souhaitent prendre des décisions trop rapidement. Le problème est que, en raison de la randomisation, il est possible que si vous laissez l’essai se poursuivre jusqu’à son terme naturel, vous obteniez un résultat différent.

Il existe également un mythe selon lequel l’essai A/B est toujours gagnant. Cela est complètement faux. Chez Google, par exemple, seuls 10 à 20% des tests menés ont des résultats positifs, et beaucoup ne donnent aucun résultat… L’échec est inhérent aux A/B tests, et c’est ça qui fait justement leur valeur :

- Si vous pensiez que quelque chose allait se produire et que c’est arrivé, vous n’avez pas appris grand-chose.

- Si vous pensiez que quelque chose allait se produire et que cela ne s’est pas produit, vous avez appris quelque chose d’important.

- Et si vous pensiez que quelque chose de mineur allait se produire, mais que les résultats sont une grande surprise et conduisent à une percée, vous avez appris quelque chose de très précieux.

6 / A nouveau, tu t’intéresseras de près à l’échantillon des populations ayant pris part à ton test

Décortiquez dans Google Analytics « qui » a été exposé à votre test pour vérifier l’homogénéité des populations

Le test AB réduit la performance à un seul & unique chiffre: la moyenne pondérée des conversions, en fonction des versions. Bien évidemment, tout le monde comprendra ici la dimension « réductrice » du test AB.

- Mais cette « simplification » n’est-elle pas le but du test AB? Oui!

- Alors quel est le problème? C’est qu’aucune action correctrice ne peut en découler.

En ne prenant pas en compte les spécificités des différents segments de visiteurs, le test AB peut faire prendre des décisions erronées.

Imaginez que vous soyez un site e-commerce. Vous vendez des produits aux particuliers CSP + de moins de 40 ans. Vous réalisez un test AB pour tester 2 versions, et voir laquelle des 2 génère le meilleur taux d’ajout au panier. Vos modifications n’ont aucun impact sur votre cible CSP+ de moins de 40 ans. Mais il se trouve que votre modification B attire plus l’oeil des > 60 ans qui « cliquent » -un peu par inadvertance- sur l’étape suivante. Que se passe-t-il? La version B va gagner les faveurs de l’A/B test.

Convaincu du bien fondé de votre décision, vous mettez en place la version B… Mais au final, vous obtenez un résultat de qualité médiocre… que vous croyez irréfutable!.. Et votre taux d’abandon du parcours grimpe en flèche, pour au final, ne vous donner aucun bénéfice supplémentaire!

Morale de cette histoire? Il existe des gens derrière les écrans connectés à Internet.

Ne les réduire qu’à une simple moyenne, sans information sur les déviations qui peuvent exister, ne peut qu’amener à une vision réductrice d’un système complexe, et à des décisions erronées.

Analysez des données basées sur les utilisateurs pour intégrer les comportements dans le temps

Le test AB ne prend pas en compte le « timing », qui peut être décisif pour votre taux de conversion. Il est également connu par tous les e-commerçants que les internautes avaient pour habitude de venir plusieurs fois sur un site avant d’être « convertis » : les ventes ne se font pas toutes en « one shot ».

Face à ce constat, une question intéressante se pose: Quel est le taux de conversion de ceux qui n’ont pas acheté la première fois, mais qui l’on fait en revenant sur le site plus tard?

Cette donnée n’est pas prise en compte dans le test A/B. Autrement dit, le test A/B est un outil « court-termiste », et ne prend pas en compte l’aspect temporel et la relation continue que vous développez avec vos internautes. Pour les entreprises qui commercialisent des produits complexes, ou ont des cycles de vente longs, le test AB n’apportera aucune pertinence au regard de l’utilisation que peuvent faire les internautes du site dans le temps.

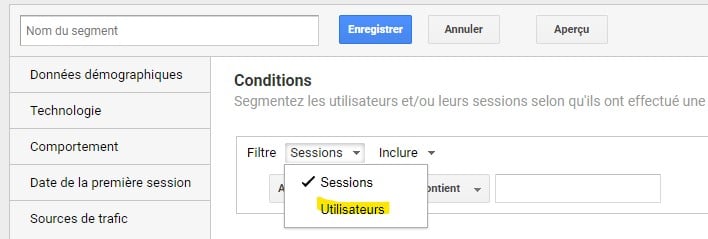

C’est pourquoi, quand vous analysez dans Google Analytics les populations ayant pris part à votre test, analysez les données en scope « Utilisateur ». Vous pourrez ainsi factoriser les comportements dans le temps.

Analyser en détail les groupes « test » et « contrôle » pour déterminer « pour qui » une version est plus efficace

Les résultats bruts dont nous disposons au terme d’un A/B test ne sont que des échantillons de populations plus importantes. Leurs propriétés statistiques peuvent donc varier.

Les entreprises doivent tirer parti des données des tests A/B non seulement pour tenter de mesurer l’efficacité globale d’une campagne auprès de tous les clients, mais aussi pour explorer quels types de clients seront les plus sensibles à certaines changements. Les marketeur ne doivent pas seulement se demander « cette variation est-elle efficace ? », mais aussi « pour qui cette variation est-elle la plus efficace ? »

Intéressez vous en priorité aux utilisateurs ayant participé à l’expérimentation qui ont le même profil que le « noyau dur » de vos clients. Combinez les résultats de vos A/B tests avec leurs données démographiques et leur historique d’achat. Vous y trouverez peut-être des avancées considérables en matière de connaissance client : peut-être qu’une caractéristique, ou un comportement, peuvent rendre un internaute plus susceptible de répondre à une variation particulière ?

7 / Avec jugement, tu interpréteras les résultats de ton A/B Test

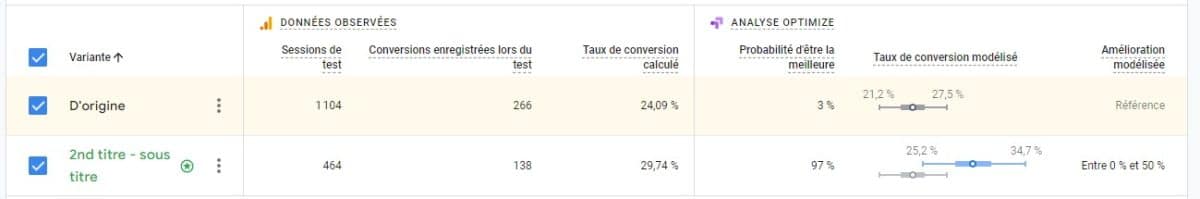

Interprétez correctement les résultats de vos A/B tests (notamment en ce qui concerne la significativité statistique)

La plupart des solutions d’A/B testing rapportent deux taux de conversion :

- un pour les utilisateurs qui ont vu la version de contrôle,

- et l’autre pour les utilisateurs qui ont vu la version de test.

Mais ils ne s’arrêtent pas là. Ils donnent également des « fourchettes ». Le rapport final d’un A/B Test pourrait ressembler à ceci : « Contrôle : 15 % (+/- 2,1 %) | Variation : 18 % (+/- 2,3 %) ». Comment interpréter ces résultats ?

- Cela signifie que 18 % de vos utilisateurs se sont convertis sur la nouvelle variante avec une marge d’erreur de 2,3 %.

- Vous pourriez être tenté d’interpréter cela comme « le taux de conversion réel se situe entre 15,7 % et 20,3 % », mais ce ne serait pas techniquement correct.

- La véritable interprétation est que si vous exécutez votre test A/B plusieurs fois, 95% du temps le taux de conversion tombera dans cette plage.

En ce qui concerne la qualité des données, il est peut aussi être judicieux d’exclure les valeurs aberrantes, d’identifier les erreurs de collecte, etc. Notamment en marketing digital, puisque l’expérimentation se déroule 100% en ligne, cette question est particulièrement cruciale. Par exemple, la présence de bots dans vos populations tests ou contrôle peuvent générer des données farfelues, et biaiser vos tests. Les marketeurs doivent également être conscients des effets de traitement hétérogènes, où certains segments peuvent subir des effets beaucoup plus importants ou plus faibles que d’autres.

Intégrer le coût d’implémentation dans l’analyse des conclusions d’A/B tests

En tant que spécialiste du marketing, il est important d’inclure les coûts de mise en œuvre lors de l’analyse des résultats des tests A/B. En effet, cela peut affecter la rentabilité du projet d’optimisation.

Les coûts de mise en œuvre peuvent inclure des coûts tels que le développement de nouvelles fonctionnalités, la formation des équipes et la mise à jour des processus. Si le coût de mise en œuvre est élevé et que le bénéfice potentiel est faible, il peut être préférable de ne pas mettre en œuvre la version réussie du test A/B.

Par conséquent, en incluant les coûts de mise en œuvre dans votre analyse, vous pouvez évaluer la rentabilité « réelle » de A/B test et déterminer quelle variation offre le meilleur retour sur investissement.

Complétez vos A/B tests avec d’autres données

Voix du client, Heatmap

Comme je l’ai mentionné plus haut, le test A/B est une méthode quantitative. En tant que tel, le test peut vous dire quelle version (A ou B) fonctionne le mieux, mais il ne vous dira pas pourquoi, ni ce qui s’est réellement passé.

Pour compléter les données quantitatives, contactez les visiteurs pour obtenir des commentaires qualitatifs afin d’avoir une image complète du comportement des utilisateurs. Vous pouvez envoyer un e-mail demandant aux utilisateurs participant au test de partager leur expérience. Par exemple, cet e-mail peut inclure un lien vers un formulaire avec une seule question. Quelque chose d’aussi simple que « Veuillez nous dire ce que vous pensez de notre nouveau design » donne aux utilisateurs un espace pour fournir leurs commentaires dans un format non structuré.

Il est également important de décomposer les composants d’une métrique prise pour évaluer le succès d’un test et de les analyser car ils fournissent généralement des informations sur les raisons pour lesquelles une idée a réussi ou échouer. Par exemple, si le nombre de clics fait partie réalisés sur une page fait partie intégrante de votre métrique clé (ex: le taux de conversion), il est essentiel de mesurer les parties de page sur lesquelles les utilisateurs ont cliqué.

Cadrage de vos A/B tests : Téléchargez le template gratuit

En complément de cet article, vous pouvez télécharger gratuitement mon template pour cadrer vos A/B tests comme un professionnel !

Il vous suffit simplement de vous abonner à ma newsletter.

8 / Continue de tester, même quand tu crois avoir trouver la variante gagnante

Optimum local & Optimum global : avons-nous réellement atteint le meilleur résultat possible ?

Dans tous chantier d’optimisation en mathématiques, on parle d’optimum global et d’optimum local. Appliqué à l’A/B test, cela signifie en réalité qu’il existe plusieurs « maximums » possibles, comme l’illustre le graphique ci-dessous.

Si tous les A/B tests répondent à cette loi, comment le marketeur peut-il être réellement sûr d’avoir atteint la performance « maximale » ?

En d’autres termes, il est impossible de déterminer avec précision à quel endroit de la courbe on se trouve quand on analyse les résultats d’un A/B test. Par exemple, une variation B peut être gagnante dans une période de solde, mais une variation C pourrait s’avérer encore meilleur dans une autre période, comme Noël…

Les résultats d’un A/B test peuvent donc nous faire croire qu’un pic de performance a été atteint, mais nous ne pouvons pas deviner si c’est le maximum local, global, ou si c’est un « accident » sur la courbe.

Osez refaire vos A/B tests de temps à autres

Mais même avec des résultats statistiquement significatifs, il existe une probabilité assez élevée d’erreurs de faux positifs. Cela est d’autant plus vrai que les gains sont mineurs : en fait, plus l’amélioration est faible, moins les résultats sont fiables.

Trop souvent, les marketeurs veulent croire que chaque petite amélioration compte, même si les résultats des tests ne sont pas entièrement fiables. Or le mieux est encore de refaire son test, pour valider & entériner définitivement vos résultats.

Malheureusement, peu d’entreprises osent retester suffisamment. Nous avons tous tendance à tester une fois, puis à croire dans des résultats définitifs. Retester une hypothèse peut être difficile à accepter parfois, car les managers peuvent obtenir des résultats contradictoires et personne ne veut découvrir que ses précédentes conclusions étaient fausses.

Evitez néanmoins de tomber dans le piège de « sur tester » votre hypothèse

Challenger de temps à autres les résultats d’A/B tests ne signifie pas non plus s’engager dans une processus infini, sans limite. Au delà du fait que cela peut devenir coûteux pour l’entreprise, retester encore et encore la même hypothèse peut être contre productive.

Par exemple, les résultats statistiques peuvent être biaisés si le marketeur réutilisent les populations de contrôle et de test d’une expérience à l’autre. Cette pratique conduit à ce que l’expérience des gens avec une variation modifie leur comportement futur. Pour éviter ce phénomène, les entreprises doivent « mélanger » les utilisateurs entre les expériences.

Donc à force de tester encore et encore, vous risquez de prendre les mauvaises décisions au fil d’A/B tests mal exécutés, dont la portée est trop étroite et les faux négatifs pris pour argent comptant…

Mieux vaudra toujours réaliser quelques A/B tests bien cadrés, avec des seuils de confiance robustes, qu’une multitude de petits A/B tests qui peuvent vous induire en erreur.

9 / Un vrai processus, tu structureras autour de l’A/B testing

Documentez les résultats de vos A/B Tests

Il n’y a rien de plus dommage qu’une entreprise qui ne sait pas capitaliser et apprendre de ses erreurs. Ce que vous apprenez au fil de vos A/B tests doit être consigné dans une base de connaissances, de manière à ce que les enseignements puissent facilement être réutilisés.

Un excellent moyen de documenter vos résultats consiste à rédiger un article de blog ou un meme rapide sur votre expérience : reprenez l’hypothèse, la méthodologie employée, les populations ayant participé à l’expérimentation et les résultats finaux bien entendu.

Concluez votre prose par les recommandations concrètes qu’implique le test, et précisez les éventuels tests à venir qui permettront d’aller plus loin. Vous pouvez également en profitez pour impliquer le reste de l’entreprise, et demander aux équipes de réagir aux résultats, de suggérez un nouveau test ou des actions à entreprendre suite à vos conclusions.

Définissez un modèle organisationnel, dédié à l’A/B testing

Tester scientifiquement ses options marketing demande des processus. Pour structurer votre démarche d’expérimentation, 3 modèles organisationnels peuvent être envisagés.

Modèle centralisé

Dans cette approche, une équipe d’analystes est au service de l’ensemble de l’entreprise, de tous les projets.

AVANTAGES

- Plus facile de se concentrer sur des projets « long terme » pour améliorer les procédés d’expérimentation

- Un effet d’expérience qui s’accumule plus rapidement.

- Une maitrise idéale des outils, qui permet de meilleures analyses, plus vite.

INCONVENIENTS

- Difficile de suivre & d’aligner les priorités des expérimentations avec les besoins changeants du marketing (goulot d’étranglement)

- Les coûts d’interface entre ces équipes et le marketing peut engendrer des coûts supplémentaires et des jeux de politique interne.

- Les équipes en charge de l’expérimentation n’ont pas les connaissances « métier », ce qui implique des efforts transversaux plus couteux.

Modèle décentralisé, qui délègue l’A/B testing aux équipes

Une autre approche consiste à répartir les analystes dans les différentes équipes divisions marketing.

AVANTAGES

- Les analystes deviennent « experts » de l’équipe marketing à laquelle ils sont rattachés.

- Plus d’agilité au quotidien, et une communication simplifiée, qui rend l’A/B testing plus efficace, et mieux adaptés aux enjeux du terrain.

INCONVENIENTS

- Des évolutions de carrières limitées en interne

- Peut provoquer des différences méthodologiques entre les différentes équipes.

- Un manque de partage des bonnes pratiques, qui ralentit l’excellence opérationnelle en matière d’A/B testing

- L’entreprise peut passer à côté d’apprentissages encore plus stratégiques via des expérimentations centrales, faites pour toutes les divisions.

Modèle hybride, qui vise à associer « le meilleur des deux mondes »

Une troisième option consiste à avoir à la fois des analystes dans une équipe centrale et d’autres au sein de équipes marketing (Microsoft utilise cette approche).

AVANTAGES

- Réduit considérablement le temps et les ressources nécessaires à l’A/B testing en créant une plate-forme d’expérimentation à l’échelle de l’entreprise et en mutualisant des outils.

- L’existence d’une entité centrale permet de mieux diffuser les bonnes pratiques de test au travers de workshops avec les équipes par exemple.

- Les équipes gardent beaucoup d’agilité, avec des ressources attitrées qui leur permettent de conduire des tests en toute autonomie.

INCONVENIENTS

- Les rôles et responsabilités entre les équipes centrales & marketing peuvent manquer de clarté.

- La manière d’assurer le contrôle de gestion peut mener à des conflits internes (certaines équipes réalisent plus de tests que d’autres).

Il n’y a pas de bon ou de mauvais modèle.

Les petites entreprises commencent généralement par le modèle centralisé avec un outil tiers, voire externalisent complètement l’A/B testing, puis envisagent éventuellement d’autres modèles si la croissance de l’entreprise le justifie.

Dans les entreprises ayant plusieurs business units, les responsables qui souhaitent tester plus, plus vite et plus souvent ne souhaiteront pas attendre que l’entreprise développe une approche organisationnelle coordonnée ; dans ces cas, un modèle décentralisé pourrait avoir du sens, du moins au début.

Et si l’expérimentation en ligne est une priorité et un enjeu stratégique, une entreprise peut souhaiter acquérir une expertise et des standards établis en central, avant de les déployer dans les différentes business units.

Conclusion

Les tests A/B sont un excellent moyen de comprendre rapidement une question que vous vous posez.

il y a des avantages à avoir la capacité d’exécuter de nombreux tests à moindre coût et simultanément, ce que de plus en plus d’entreprises commencent à reconnaître.

Toute entreprise qui compte au moins quelques milliers d’utilisateurs actifs quotidiens peut effectuer ces tests. La possibilité d’accéder à de grands échantillons de clients, de collecter automatiquement d’énormes quantités de données sur les interactions des utilisateurs sur les sites Web et les applications, et d’exécuter des expériences simultanées offre aux entreprises une opportunité sans précédent d’évaluer de nombreuses idées rapidement, avec une grande précision et à un coût négligeable par incrément. expérience. Cela permet aux organisations d’itérer rapidement, d’échouer rapidement et de pivoter.

Les retours que vous tirez des tests A/B (en termes d’économies, de nouveaux revenus et d’amélioration de l’expérience utilisateur) peuvent être énormes.

Cadrage de vos A/B tests : Téléchargez le template gratuit

En complément de cet article, vous pouvez télécharger gratuitement mon template pour cadrer vos A/B tests comme un professionnel !

Il vous suffit simplement de vous abonner à ma newsletter.

FAQ A/B Test

Qui a inventé l’A/B test ?

Dans les années 1920, le statisticien et biologiste Ronald Fisher a découvert les principes les plus importants derrière les tests A/B. Fisher a mené des expériences agricoles, posant des questions telles que : « que se passe-t-il si je mets plus d’engrais sur cette terre ? »

Les principes ont persisté et au début des années 1950, les scientifiques ont commencé à mener des essais cliniques en médecine. Dans les années 1960 et 1970, le concept a été adapté par les spécialistes du marketing pour évaluer les campagnes de marketing direct).

De nos jours, les A/B tests sont surtout utilisés en marketing digital.

Quel est l’objectif d’un test A/B ?

L’objectif d’un test A/B est de comparer deux versions d’un élément marketing pour déterminer laquelle est la plus performante en termes de conversions, de taux de clics, de taux d’engagement, entre autres indicateurs.

En comparant les performances de deux versions différentes d’une page Web, d’un e-mail, d’une annonce publicitaire, etc., les marketeurs peuvent prendre des décisions « scientifiques » pour optimiser les performances de leur stratégie marketing.

Les tests A/B permettent aux marketeurs de comprendre ce qui fonctionne et ce qui ne fonctionne pas, et d’améliorer les performances en conséquence.

Comment faire un test A/B ?

En tant que marketeur digital, pour effectuer un test A/B, vous pouvez suivre les étapes suivantes :

- Définir votre objectif : déterminer ce que vous voulez tester, comme par exemple le taux de clics sur un bouton d’appel à l’action.

- Sélectionner la variable à tester : décidez de ce que vous allez changer pour chaque version de votre page, par exemple le texte sur le bouton d’appel à l’action.

- Créer vos versions de test : utilisez un outil de création de page pour créer deux versions de votre page, la version A et la version B, en modifiant la variable sélectionnée.

- Configurer la segmentation des populations test & contrôle : décidez comment vous allez diviser votre public en deux groupes pour les exposer, chacune d’entre elles, à une de vos variations.

- Effectuer le test : lancez le test en exposant la population contrôle la version A et la population test à la version B.

- Mesurer les résultats : utilisez un outil d’analyse pour suivre les taux de conversion pour chaque version de la page et déterminer laquelle est la plus performante.

- Analyser et tirer des conclusions : examinez les données pour comprendre pourquoi une version de la page a fonctionné mieux que l’autre, et mettez en œuvre les enseignements pour améliorer les performances de votre site Web à l’avenir.

Il est important de se rappeler que les tests A/B ne sont qu’un outil parmi d’autres pour aider à améliorer les performances marketing. Il est important d’utiliser une approche rigoureuse pour garantir des résultats fiables et de continuer à tester et à apprendre de manière continue.

Quel est l’avantage principal de l’A/B testing ?

Le principal avantage de l’A/B testing est la capacité qu’il offre aux marketeurs à prendre des décisions « informées « scientifiques » sur les stratégies marketing employées en comparant deux versions d’un élément marketing pour déterminer laquelle est la plus performante. Cela permet aux marketeurs de comprendre ce qui fonctionne et ce qui ne fonctionne pas, et d’optimiser les performances en conséquence, sans devoir prendre des décisions basées sur des hypothèses ou des suppositions. L’A/B testing fournit également une preuve concrète et quantifiable des résultats, ce qui peut aider à justifier les décisions marketing et les investissements en temps et en argent. En fin de compte, l’A/B testing peut améliorer l’efficacité et l’efficience de la stratégie marketing en générant des résultats plus importants pour les entreprises.

Cadrage de vos A/B tests : Téléchargez le template gratuit

En complément de cet article, vous pouvez télécharger gratuitement mon template pour cadrer vos A/B tests comme un professionnel !

Il vous suffit simplement de vous abonner à ma newsletter.

Autres sources pour rédaction

A Refresher on A/B Testing

The Surprising Power of Online Experiments

Research: When A/B Testing Doesn’t Tell You the Whole Story

Why “Only One Change Per Test” Isn’t Good Advice