Aviez-vous remarqué que les médias essayent régulièrement de nous convaincre d’une révolution technologique imminente ? L’année dernière, c’était avec le métavers. L’année précédente, c’était avec la blockchain. Il y a 5 ans, c’était déjà avec l’intelligence artificielle. Si l’engouement initial pour l’IA était retombé, les modèles génératifs relancent la machine médiatique qui s’emballe à nouveau pour des technologies et usages qui sont spectaculaires, mais n’ont rien de révolutionnaire, du moins pas si l’on prend un minimum de recul.

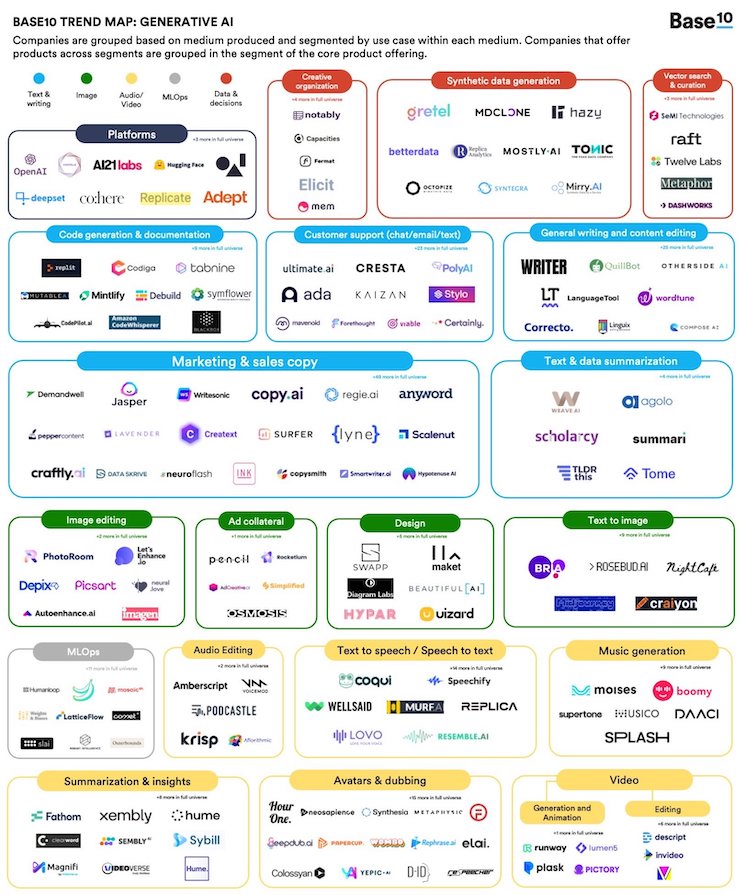

Si vous vous intéressez un minimum aux usages numériques et à l’actualité IT, il ne vous aura pas échappé que le marché est à nouveau en ébullition. Ces derniers mois, nous constatons ainsi un énorme engouement médiatique autour des modèles génératifs (les “creative AI”) depuis la mise à disposition de services permettant de créer des images (ex : Dall-E, Midjourney Stable Diffusion…).

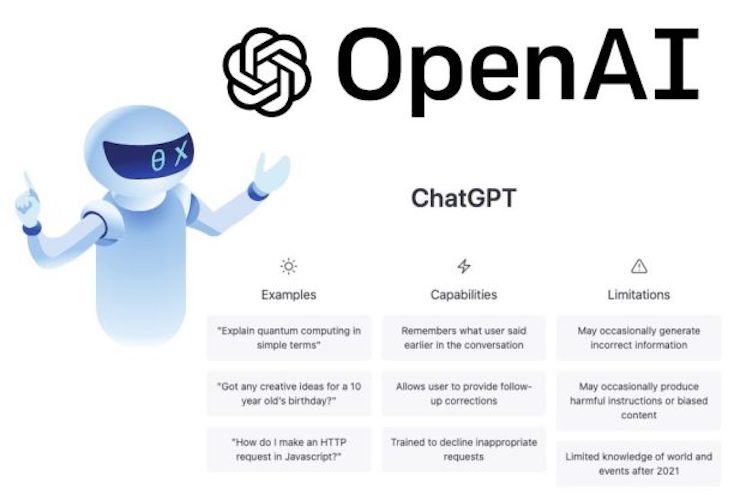

Nous avons franchi un nouveau palier d’enthousiasme avec l’ouverture au grand public d’un service en ligne pour tester ChatGPT, un agent conversationnel développé par OpenAI qui est spécialisé dans la génération de contenus textuels.

Depuis quelques semaines, nous avons droit à une avalanche de prédictions toutes plus spéculatives les unes que les autres qui prophétisent l’avènement de l’IA “nouvelle génération” et la disparition de nombreux métiers (rédacteur, traducteur, écrivain, professeurs…). Pourtant, la réalité est tout autre, car comme pour les précédentes “innovations disruptives”, il y a de nombreux facteurs à prendre en compte avant de décréter que le point d’inflexion est enfin atteint. De plus, les nouveaux prophètes semblent oublier que dans l’absolu, ChatGPT n’est qu’un assistant numérique proposé avec une interface textuelle (l’équivalent de Siri, Alexa ou de l’assistant Google, mais sans synthèse vocale).

À ce stade, je pense qu’il est (à nouveau) temps de briser quelques mythes et d’exposer un point de vue réaliste et pragmatique. Non, ceci n’est pas un article polémique, simplement une prise de recul pour bien comprendre la complexité de l’écosystème numérique.

Fin de la lune de miel médiatique pour les IA génératives

Régulièrement, nous avons droit à des phénomènes d’emballement médiatique pour des innovations technologiques. Les derniers en date concernaient l’informatique quantique, la blockchain ou le métavers (cf. Fin de la lune de miel médiatique pour le Web3 et le métavers).

Concernant les modèles génératifs, et plus précisément celui proposé par OpenAI, la réaction des experts a été rapide. Ainsi, c’est Yann LeCun qui a été le premier à jeter un pavé dans la mare et à relativiser le caractère disruptif de cet agent conversationnel : ChatGPT is ‘not particularly innovative,’ and ‘nothing revolutionary’, says Meta’s chief AI scientist.

Avant lui, signalons la publication du livre “Snake Oil” en 2019 qui nous mettait déjà en garde contre les recettes miracles liée aux intelligences artificielles, et dont l’auteur a été interviewé pour l’occasion : Decoding the Hype About AI.

Au cas où vous vous poseriez la question, Yann LeCun est un chercheur en intelligence artificielle qui est considéré comme l’un des inventeurs du deep learning, et dont les travaux remontent aux années 80 avec notamment les premiers expérimentations sur la reconnaissance d’image et leur mise en application par le Crédit mutuel de Bretagne pour la lecture optique de chèques. Je pense ne pas me tromper en écrivant que ce monsieur connaît son sujet.

De même, Arvind Narayanan est un chercheur à l’université de Princeton dont les travaux portent, entre autres, sur l’impact des technologies numériques et plus particulièrement de l’intelligence artificielle. Ici un extrait simplifié de son livre en 20 diapos : How to recognize AI snake oil (PDF).

Autre scientifique à remettre l’église au milieu du village : Stephen Wolfram, un chercheur britannique qui a obtenu un doctorat en physique des particules à 20 ans, connu pour son logiciel de calcul Mathematica, mais également pour WolframAlpha, un service en ligne à mi-chemin entre moteur de recherche et outil de calcul en langage naturel. Dans cet article limpide, il nous explique les différences entre ChatGPT et son service : Wolfram Alpha as the Way to Bring Computational Knowledge Superpowers to ChatGPT.

Il n’y a pas que le monde scientifique qui s’en mêle, puisque le Time Magazine a publié un article pour révéler l’envers du décor de ChatGPT et ces sous-traitants kenyans payés une misère pour “nettoyer” le modèle : OpenAI Used Kenyan Workers on Less Than $2 Per Hour to Make ChatGPT Less Toxic. Puis c’était au tour de CNET de nous expliquer qu’ils ont expérimenté les modèles génératifs pendant quelques mois avant d’arrêter l’expérience : CNET Is Experimenting With an AI Assist, Here’s Why. La raison invoquée est que ces modèles demandent un gros travail de relecture et de vérification. Un point de vue confirmé par le journal Futurism qui révèle les nombreuses erreurs, approximations et plagiats publiés pendant cette période : CNET’s Article-Writing AI Is Already Publishing Very Dumb Errors.

J’en profite pour vous rappeler que le mythe du robot-rédacteur existe depuis de nombreuses années et que les professionnels des médias les utilisent avec plus ou moins de succès : ChatGPT in journalism: Let’s not have an identity crisis.

Toutes ces personnes sont-elles folles ? Sont-elles trop stupides pour ne pas détecter le potentiel des IA génératives ? Je ne pense pas. Si je devais faire une supposition, ça serait que ce sont plutôt les personnes qui prophétisent la révolution de l’IA qui n’ont pas assez travaillé leur sujet. Ou peut-être que la vérité est ailleurs : peut-être que la rigueur scientifique n’est pas compatible avec le niveau de qualité des contenus générés par les intelligences artificielles. En tout cas, les difficultés exposées par la rédaction de CNET ne semblent pas poser de problème aux fermes à contenus qui y voient une très belle opportunité : BuzzFeed to Use ChatGPT Creator OpenAI to Help Create Quizzes and Other Content.

Le fond du débat est que ce n’est pas tant la technologie sous-jacente qui est révolutionnaire que l’emballage.

Une tactique marketing digne des marques de lessives

Il y a 13 ans, je publiai cet article qui décrit un moteur de recherche de nouvelle génération exploitant une interface visuelle : Qwiki inaugure l’avenir de la recherche sur terminaux alternatifs.

Certes, la technologie utilisée par ce service n’a rien à voir avec les modèles génératifs, mais le procédé est le même : changer l’habillage du produit à défaut d’améliorer le produit.

En ce sens, ChatGPT se distingue avant tout par son interface, puisque les modèles génératifs existent depuis de nombreuses années, mais n’étaient pas accessibles au grand public. Nous pouvons faire ici une comparaison très juste avec les navigateurs (qui sont devenus populaires avec Netscape Navigator), les baladeurs numériques (qui sont devenus populaires avec l’iPod) ou les smartphones (popularisés par l’iPhone). Dans ces trois exemples, ce n’est pas la technologie qui a changé la donne, mais sa mise sur le marché à travers un produit bien packagé : ChatGPT: Netscape Moment or Nothing Really Original.

Vous pourriez me dire : “Mais oui, c’est justement ça la révolution !“. Et je vous répondrai que malheureusement les choses ne sont pas aussi simples et qu’ériger ChatGPT en révolution potentiellement aussi importante que celle de l’informatique, c’est prendre un raccourci grossier et mettre de côté la dynamique et les règles du marché (cf. Pourquoi ChatGPT est une révolution « comparable à l’apparition de l’ordinateur »). Encore une fois, c’est oublier que les assistants numériques comme Siri, Alexa ou Google Assistant existent depuis plus de 10 ans (lire à ce sujet cet article publié en 2017 : Les assistants personnels sont les nouveaux navigateurs web et les GAFAM en sont les maitres absolus)

Pour vous la faire simple : Avec ChatGPT, OpenAI nous refait le coup des enzymes gloutons. L’idée est de mettre sur le marché un produit satisfaisant (“good enough” comme disent les Américains), mais suffisamment attractif pour provoquer l’émerveillement du grand public à travers la distribution d’échantillons. Les beta publiques de Dall-E ou ChatGPT sont ainsi le moyen qu’utilise OpenAI pour imposer son produit sur le marché en prenant la concurrence de vitesse. L’idée générale est de commoditiser l’intelligence artificielle en installant une marque (l’équivalent de “Intel Inside“). Pour mémoire, il y a 20 ans les publicités essayaient de nous faire croire que les ordinateurs équipés de processeurs Intel permettaient de surfer plus vite sur le web.

Face à l’adoption rapide des modèles génératifs, de nombreux acteurs commencent déjà à faire machine arrière : banques d’images (Getty Images Has Started Legal Proceedings Against an AI Generative Art Company For Copyright Infringement), plateformes de publication (How we’re approaching AI-generated writing on Medium) ou éditeurs (ChatGPT can’t be credited as an author, says world’s largest academic publisher).

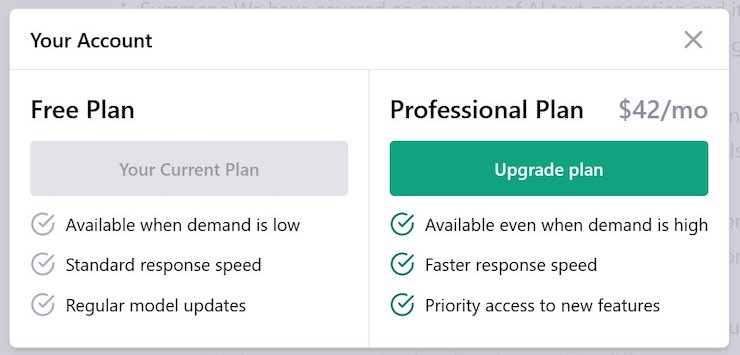

Qu’à cela ne tienne, OpenAI s’est trouvé avec Microsoft un partenaire financier et technologique de choix pour pouvoir assurer son développement : Microsoft invests billions more dollars in OpenAI, extends partnership. Les équipes de Redmond nourrissent de très grandes ambitions autour de l’intégration de GPT : How Microsoft can become the biggest winner of generative AI et ‘AI is going to reinvent how you do everything on Windows,’ says Microsoft’s Windows boss. Leur idée étant manifestement d’augmenter la valeur perçue des solutions, ou à défaut leur prix de vente. Car oui, au cas où vous vous poseriez la question : ces modèles génératifs sont pour le moment librement accessibles, mais ils ne sont pas gratuits. Une version payante du service est d’ailleurs en accès limité : ChatGPT Pro: Early Access Users Share Their Thoughts.

Le problème n’est pas tant le prix que le cadre juridique, puisqu’avec un service payant, vous passez des Conditions Générales d’Utilisation aux Conditions Générales de Vente, un cadre plus contraignant.

Pour l’anecdote, sachez qu’OpenAI est passé en 2019 du modèle “non lucratif” à celui de “but lucratif plafonné” avec une limite de 100 fois les montants investissements (OpenAI shifts from nonprofit to ‘capped-profit’ to attract capital). Sachant que Microsoft a investi 10 MM$, ça nous donne une limite de profits à… 1.000 milliards de $ !

Se pose maintenant la question du modèle économique pour les futurs clients : est-ce rentable ?

La question n’est pas de savoir ce que peut faire une IA générative, mais combien vous pouvez facturer son travail

Le sujet des modèles génératifs n’est pas neuf, car je l’avais déjà abordé l’année dernière : Les IA génératives annoncent une révolution dans les médias et la publicité. Si le potentiel pour les médias est (en théorie) gigantesque, la mise en oeuvre des contenus synthétiques à grande échelle risque d’être plus compliquée que prévu.

Le principal problème est que ces modèles génératifs sont construits sur la base de vastes jeux de données d’entrainements récupérés sur le web. En l’occurrence, GPT a été conçu avec quasiment tous les contenus en ligne disponibles jusqu’en 2021 (la date de sa publication). Des contenus qui sont accessibles gratuitement, mais pas libres de droits.

Au regard de la rapidité d’adoption de ces outils, et surtout des investissements réalisés par Microsoft, les ayants droits se mobilisent pour éviter de se faire piller gratuitement leur savoir-faire : Generative AI should pay human artists for training.

Depuis les annonces faites pas Microsoft, les avocats salivent d’avance et commencent à monter des dossiers de recours collectifs pour essayer de récupérer une part du gâteau : AI art tools Stable Diffusion and Midjourney targeted with copyright lawsuit. Idéalement, les créateurs des contenus ayant servis à entrainer le modèle souhaiteraient toucher des droits d’auteur, ce qui entre nous serait tout à fait logique.

À titre d’illustration, les articles de blog sont publiés sous la licence Creative Commons BY-NC-SA 4.0 qui stipule que personne n’est autorisé à en faire un usage commercial. Je trouverai anormal qu’OpenAI facture l’utilisation d’un service permettant de faire des résumés des mes articles ou de reproduire mes schémas alors que je les ai publiés gratuitement.

Nous touchons ici du doigt un énorme problème que tous les apôtres de la “révolution de l’IA” semblent avoir négligé : ChatGPT Will Unleash Copyright Chaos. Autant vous le dire tout de suite : je n’ai pas d’avis éclairé à vous donner tant la question des droits d’auteur est complexe, et surtout dépendante de la jurisprudence de chaque pays où elle est appliquée (What Does Copyright Say about Generative Models? Not much.). Ce qui est certain, c’est que le succès actuel des modèles génératifs repose sur un vide juridique qui va très rapidement être comblé, comme c’est déjà le cas ailleurs dans le monde : China bans AI-generated media without watermarks.

En mettant son modèle génératif à disposition du grand public, les équipes d’OpenAI ne se doutaient pas qu’elles allaient ouvrir la boîte de Pandore… ou peut-être bien que si… La question que l’on se pose maintenant est : Y a-t-il une vraie raison de paniquer ?

Qu’est-ce que peut ou ne peut pas faire un modèle génératif ?

À ce stade de mon argumentation, il me semble important de préciser certains détails techniques, et notamment le fonctionnement des modèles génératifs, tous les modèles, pas que ChatGPT.

Comme l’explique fort justement Yann LeCun dans son interview, OpenAI n’est qu’un des laboratoires de recherche qui travaillent sur l’IA depuis de nombreuses années. Dans l’absolu, ils n’ont fait qu’assembler des briques technologiques issues de la recherche universitaire. En ce sens, GPT n’est pas réellement une innovation disruptive, simplement un déploiement à plus grande échelle que ses concurrents. Et surtout : les modèles génératifs ne sont pas des solutions miracles capables de résoudre tous les problèmes, uniquement des logiciels de traitement avec une grosse base de données.

Au risque de vous choquer : une intelligence artificielle est incapable de raisonnement, elle simule un raisonnement (tout est dans le terme : intelligence AR-TI-FI-CIELLE). Les modèles génératifs reposent ainsi sur des calculs probabilistes : ils affichent la réponse qui a le plus de chance de correspondre à la question, en fonction de ce qu’ils ont vu ailleurs.

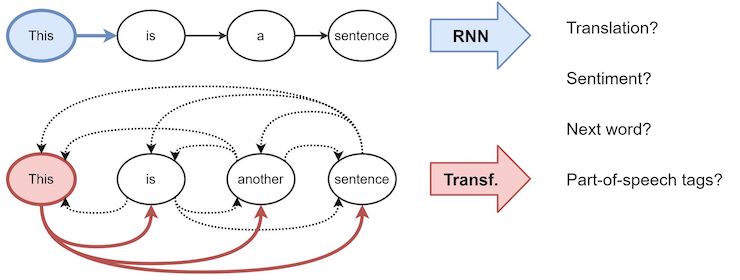

Pour résumer une longue explication : les IA génératives utilisent des modèles d’apprentissage profond qui reposent sur des réseaux de neurones artificiels. Certes, les pratiques de deep learning ne sont pas nouvelles, mais il y a eu une avancée majeure en 2017 avec la mise au point par les équipes de Google des transformeurs, des modèles auto-attentifs concurrents aux réseaux de neurones récurrents et réseaux de neurones convolutifs, qui sont utilisés dans le domaine du traitement automatique du langage.

Pour une explication plus détaillée, je vous recommande l’article de Wikipedia sur les transformeurs :

À l’instar des réseaux de neurones récurrents (RNN pour “Recurrent Neural Network”), les transformeurs sont conçus pour gérer des données séquentielles, telles que le langage naturel. Contrairement aux RNN, les transformeurs n’exigent pas que les données soient traitées dans l’ordre. Cela permet une parallélisation beaucoup plus importante que les RNN et donc des temps d’entraînement réduits. Étant donné que le modèle transformeur facilite la parallélisation pendant la phase d’entraînement, celui-ci peut s’effectuer sur des ensembles de données plus volumineux. Ce gain de temps a conduit au développement de systèmes pré-entraînés tels que BERT et GPT, des modèles créés à partir d’énormes ensembles de données de texte général, tels que Wikipedia Corpus.

Les deux principaux modèles génératifs sont ceux de Google et d’OpenAI, mais il existe de nombreux autres projets (LSTM, Transformers, GPT, BERT : guide des principales techniques en NLP). Néanmoins, si l’on parle autant de GPT-3, le modèle d’OpenAI, c’est car le volume de données analysé est très impressionnant : 175 milliards de paramètres. Avec BERT et GPT, nous sommes rentrés dans l’ère des modèles de langage étendus (LLM pour “Large Language Models“) qui proposent des déclinaisons spécifiques à certains traitements : Dall-E pour la génération d’images, Codex pour la génération de code, ChatGPT pour la génération de texte.

Mais ça ne s’arrête pas là, car les modèles génératifs peuvent être utilisés dans d’innombrables cas d’usage, et surtout encapsulés dans de nombreux services en ligne.

C’est bien simple : GPT est ce qui se rapproche le plus d’une intelligence artificielle généraliste, c’est à dire capable de traiter de nombreuses tâches. Et dans cette logique, plus de paramètres = plus de contenus ingurgités = plus de chances de trouver la réponse à une question. Voilà pourquoi nous assistons maintenant à une véritable course à l’armement avec la sortie prochaine de GPT-4, la nouvelle itération du modèle génératif d’OpenAI et ses 100 trillions de paramètres, une surenchère déjà démentie par le patron (OpenAI CEO Sam Altman on GPT-4: ‘people are begging to be disappointed and they will be’).

Je ne souhaite pas m’étendre plus sur les explications techniques, car je risque rapidement de sortir de mon champ de compétences, mais retenez simplement que le modèle ne sera jamais plus intelligent que ce qu’il a lu.

Illustration :

Ceci nous confirme ce que nous savions déjà : les IA génératives n’ont pas vraiment conscience de ce qu’elles génèrent, il est possible de leur faire dire n’importe quoi, et même des choses dangereuses (Le prochain super propagateur d’infox : comment ChatGPT pourrait diffuser des infox toxiques à large échelle et ChatGPT : l’intelligence artificielle au service du complotisme ?).

De façon assez contre-intuitive, les intelligences artificielles se révèlent performantes là où nous pensions qu’elles allaient échouer (les contenus créatifs) et plutôt faibles là où nous pensions qu’elles allaient exceller (le raisonnement logique et la résolution de problème).

Ave ces exemples de dialogues absurdes, on se demande comment certains peuvent affirmer que Google pourrait être rapidement remplacé par ChatGPT… Ceci étant dit, le vrai danger pour Google et les autres moteurs de recherche n’est pas tant la capacité des IA de trouver de meilleures réponses, mais plutôt de les afficher dans une interface où il n’y a plus de place pour les résultats sponsorisés, la poule aux oeufs d’or de Google qui rapporte plus de 200 milliards de $ par an. En ce sens, effectivement, des moteurs de recherche de nouvelle génération peuvent potentiellement représenter une menace pour le modèle économique des moteurs traditionnels : A New Chat Bot Is a ‘Code Red’ for Google’s Search Business (si l’on met de côté l’assistant Google lancé en 2016). Les chinois de Baidu sont d’ailleurs déjà en train de plancher sur la question : Chinese Search Giant Baidu to Launch ChatGPT-Style Bot.

Y a-i-il réellement un danger pour Google ? C’est pour le moment difficile à dire, car l’engouement médiatique est réellement fort et nous n’en connaissons pas les impacts. Ce qui est certain, c’est que les équipes de Google se sont empressées de communiquer sur le fait qu’elles étaient à l’origine des travaux sur les transformeurs et que de nombreuses avancées ont été réalisées depuis : Google Research, 2022 & beyond: Language, vision and generative models. La rumeur court que les deux fondateurs de Google auraient été appelés à la rescousse pour étudier tous les scénarios et éviter un mouvement de panique des actionnaires : Google Calls In Help From Larry Page and Sergey Brin for A.I. Fight.

La conclusion que l’on peut tirer de cette histoire est que les intelligences artificielles sont des outils très puissants, à ne pas mettre entre toutes les mains. D’ailleurs, les géants numériques comme Google ou Microsoft sont tout à fait conscients des dangers potentiels des IA, puisqu’ils en ont une approche très prudente : Microsoft and the learnings from its failed Tay artificial intelligence bot et Google fires Blake Lemoine, the engineer who claimed AI chatbot is a person. Une prudence qui visiblement n’est pas de mise chez OpenAI où l’on a décidé de prendre le marché de vitesse : Big Tech was moving cautiously on AI. Then came ChatGPT.

Il y a donc une réelle nécessité pour les utilisateurs de ces outils de comprendre leur fonctionnement et surtout de bien en appréhender les limites. D’ailleurs, après avoir fait parler les prophètes et vendeurs de miracles, les médias donnent maintenant la parole à des professionnels adoptant une approche plus prudente des IA :

Ceci nous amène à une question intéressante : est-ce les vendeurs de solutions miracles qui nous mènent en bateau ou les médias ? D’autant plus que nous sommes déjà passés par là…

Il y a déjà eu une première bulle de l’IA

Vous ne vous en souvenez peut-être pas, mais il y a 5 ans, le marché avait déjà connu une première vague d’enthousiasme sans bornes pour l’intelligence artificielle, avec de nombreux débats d’experts et surtout des questionnements juridico-philosophiques (ex : Qui est responsable en cas d’accident impliquant une voiture autonome ?).

Je vous invite ainsi à relire la série d’articles que j’avais publiés en 2017 :

Croyez-le ou non, mais en 5 ans, le débat n’a pas beaucoup progressé. En revanche, je constate que les outils mentionnés il y a 5 ans ont petit à petit été perfectionnés et offrent maintenant des fonctionnalités redoutablement efficaces comme c’est le cas de Copy.ai ou Descripte qui proposent de l’édition assistée sans en faire des caisses, contrairement à des solutions plus récentes comme Tome qui nous vend du “generative storytelling“.

La promesse formulée est ici très alléchante, mais représente un réel risque de banalisation des contenus, donc de tirer le marché vers le bas, et surtout asservir l’humain !

L’IA est votre amie, ou pas ! (ça dépend)

Passés les premiers tests et l’émerveillement de la nouveauté, on se rend vite compte que les IA génératives peuvent apporter plus de problèmes de que solutions : Lyon, la moitié des élèves d’un master surpris en train de tricher grâce à l’intelligence artificielle. Il devient alors essentiel de bien comprendre les enjeux des modèles génératifs, et de l’IA de façon plus générale, afin de ne pas perturber le fonctionnement de notre société (à travers les médias, l’enseignement…) : The Dangers of AI Writing and How to Spot AI-Generated Text.

Selon moi, le plus gros danger est que les modèles génératifs nous rendent encore plus fainéants et nous incitent à utiliser les IA pour apprendre et raisonner à notre place. Il est donc de notre responsabilité d’apprendre à travailler avec les IA plutôt que de chercher à leur confier notre travail sans se soucier des conséquences. Une question que j’avais déjà abordée en 2018 : L’intelligence artificielle est un outil de productivité comme les autres.

Loin de moi l’idée de jouer les techno-réfractaires, ceux qui me lisent régulièrement savent que je reste très optimiste, mais il est important de ne pas reproduire les erreurs du passé, notamment la généralisation trop rapide d’outils numériques auprès de publics pas forcément bien préparés (cf. Réseaux sociaux : une jeunesse fracassée).

Le second danger serait de penser que les intelligences artificielles vont nous aider à résoudre les problèmes de notre société. Comme nous venons de le voir plus haut, les IA ne savent trouver les réponses qu’à des problèmes déjà identifiés. Nous, les humains, sommes ainsi confrontés à des défis que nous ne savons pas encore résoudre, notamment la transition énergétique (pour se passer de la dépendance aux ressources fossiles), la transition alimentaire (pour se passer de la dépendance à la viande ou au blé), le vivre ensemble (parvenir à cohabiter malgré des points de vue et intérêts divergents)…

En synthèse : Nouvelle civilisation = nouveaux défis. Des défis que les machines ne parviendront certainement pas à résoudre à notre place si elles se contentent d’analyser ce qui est publié sur le web (cf. Les macro-tendances et grands enjeux qui vont façonner la civilisation numérique du 21e siècle). Quel rapport entre les IA génératives et les défis du 21e siècle ? Tout simplement notre tendance à nous bercer d’illusions, alors que notre société s’enlise dans une impasse économique et sociale (ici un article intéressant publié dans le Brussels Times en 2020 : How Artificial Intelligence could transform the European economic and political landscape).

Peut-être que la première étape pour pouvoir aborder ce débat de façon sereine serait que nous acceptions le fait qu’homo sapiens a franchit un palier d’évolution et que nous sommes maintenant tous des cyborgs. Ainsi, l’homme du 21e siècle s’apparente à un organisme cybernétique : la symbiose d’une enveloppe charnelle et de terminaux numériques lui donnant accès à une infinité de contenus et services en ligne (via les ordinateur, smartphone, objets connectés…). Tout individu éloigné des outils numériques se retrouve malheureusement marginalisé dans une société qui en fait un usage intensif, que ce soit sur le plan personnel (loisirs, socialisation…) ou professionnel (travail, formation…). Tant que le grand public n’aura pas accepté cet état de fait, nous ne pourrons pas intégrer de façon harmonieuse l’intelligence artificielle et les outils numériques à nos activités quotidiennes : éducation, travail, formation, loisirs… (cf. De la nécessité d’un nouveau contrat social pour homo numericus).

Moralité : la révolution des intelligences artificielles (génératives ou autres) n’aura pas lieu, car elle a déjà commencé depuis longtemps. Nous ne sommes pas dans un scénario disruptif, mais sur une évolution progressive des usages et pratiques professionnelles, les médias généralistes et le grand public n’en ont simplement pas conscience, tout comme des enjeux et dérives potentielles. Charge à nous, les professionnels du numérique, d’éduquer correctement le marché en évitant de faire des promesses impossibles à tenir ou des projections surréalistes.