Il aura fallu moins d’un an à ChatGPT pour relancer l’intérêt sur l’intelligence artificielle et initier une nouvelle vague d’enthousiasme et de craintes. Moins d’un an également pour qu’OpenAI explose en plein vol, victime d’une croissance trop rapide et des divergences internes sur la bonne utilisation des modèles génératifs. L’avenir nous dira qui des techno-optimistes ou des techno-pessimistes a eu raison, ou plutôt lesquels ont eu raison trop tôt ou tard. Le fond du problème étant que l’intelligence artificielle est un sujet bien trop vaste, aux implications bien trop importantes pour être laissées à la libre appréciation de quelques individus, et surtout que nous avons collectivement attendu trop longtemps pour opérer les changements nécessaires afin de faire face aux enjeux du XXIe siècle.

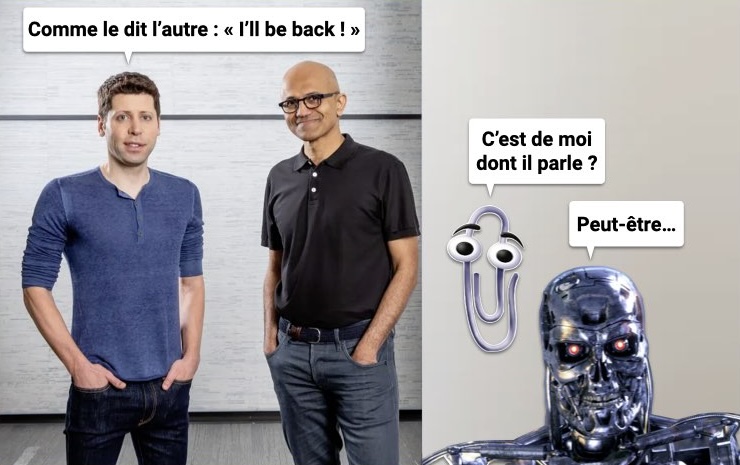

Pour celles et ceux qui n’ont pas suivi l’actualité des NTIC, sachez que ce week-end a été riche en annonces et en rebondissements. Tout a commencé dans la nuit de vendredi avec l’annonce surprise du licenciement du patron d’OpenAI par le Conseil d’Administration : Sam Altman ousted as OpenAI’s CEO. Cette annonce a été suivie de tractations dans le week-end pour son éventuel retour qui ont finalement échouées et abouties à la nomination d’un nouveau CEO (transfuge de Twitch), ce qui a provoqué une vague de démissions : Dozens of Staffers Quit OpenAI After Sutskever Says Altman Won’t Return. Puis ce lundi matin, il y a eu l’annonce de l’embauche des anciens CEO et Président d’OpenAI par Microsoft pour y monter une nouvelle équipe dédiée bien évidemment à l’intelligence artificielle : OpenAI co-founders Sam Altman and Greg Brockman to join Microsoft. Sauf qu’un bras de fer est en cours pour ré-embaucher Sam Altman, d’un côté avec les clients qui menacent d’aller à la concurrence (OpenAI’s Customers Consider Defecting to Anthropic, Microsoft, Google), et de l’autre avec les salariés qui menacent de démissionner en masse (Nearly All of OpenAI Staff Threaten to Go to Microsoft If Board Doesn’t Quit). Du coup, il se peut qu’il revienne (Sam Altman is still trying to return as OpenAI CEO), d’autant plus que l’on commence à déterrer les casseroles du nouveau patron (Emmett Shear, OpenAI’s new CEO, has a long history of questionable tweets).

De mémoire, je n’avais jamais été témoin d’une succession d’événements aussi retentissant en si peu de temps, même avec le rachat de Twitter par Elon Musk. Une mésaventure rocambolesque qui illustre bien la frénésie autour des IA génératives et qui laisse deviner les enjeux colossaux des changements induits par l’intelligence artificielle.

Je profite de ces événements pour justement faire le point sur la montée en puissance de l’IA et ses implications, en commençant par comprendre ce qui s’est passé.

De l’impossible mariage entre non profit et for profit

Comme annoncé dans l’introduction, ces derniers jours ont été particulièrement agités. L’histoire n’est pas finie, mais nous en savons un petit peu plus sur la suite d’événements de ce WE : A timeline of Sam Altman’s firing from OpenAI, and the fallout. Il y aura très certainement des livres et de nombreux reportages sur la croissance fulgurante d’OpenAI et le gros cafouillage qui en a découlé, ainsi que des révélations, mais pour le moment je vous propose de nous en tenir aux faits connus.

De ce que nous en savons, tout est histoire d’alignement des valeurs et de culture. Pour résumer : OpenAI est un petit laboratoire de recherche dont l’ambition est de faire progresser la recherche sur l’intelligence artificielle pour le bénéfice de l’humanité par le biais de ses travaux sur les larges modèles de langage, la série des GPT.

Cette initiative “non profit” a été complétée récemment par un projet “for profit” avec la création d’une filiale commerciale chargée de monétiser les travaux à travers des offres payantes. S’en est suivi une folle ascension depuis le lancement de ChatGPT, puis de l’API, puis de GPT-4, puis de DALL-E 3, puis des GPTs. Un succès flamboyant comme seule la Silicon Valley sait en produire avec aux manettes un Sam Altman rayonnant qui a fait le tour du monde pour promouvoir sa société et est devenu la figure de proue d’une nouvelle vague d’entrepreneurs potentiellement capables de détrôner les Big Techs.

Grisé par sa soudaine exposition médiatique, Sam Altman s’est peut être un peu trop emballé, victime de son optimisme, créant un désaccord grandissant avec le Conseil d’Administration qui ne voyait pas d’un très bon oeil le rythme effréné de mise sur le marché de produits à peine viables d’un point de vue technique (ChatGPT down after major outage impacting OpenAI systems). La goutte d’eau qui a fait déborder le vase est très certainement l’annonce prématurée du lancement prochain de GPT-5 (OpenAI CEO Sam Altman Says His Company Is Now Building GPT-5). Au final, ce choc des cultures entre les velléités altruistes des membres du Conseil d’Administration et la recherche d’hyper-croissance du CEO a mené au clash : Inside the Chaos at OpenAI.

Petit rappel pour bien appréhender ce choc des cultures : le crédo informel, mais tacitement accepté de la Silicon Valley est : “Fake it until you make it“. Dans ce contexte frénétique pour la course à la domination entre OPenAI et les big techs, pas étonnant que les membres du Conseil d’Administration aient petit à petit perdu la confiance en Sam Altman et décidés de le démettre de ses fonctions pour pouvoir poursuivre sereinement la mission d’OpenAI (qui est explicitement décrite dans la présentation de la société ou dans la feuille de route).

Bien évidemment, vu l’ampleur des discussions générées par les événements de ce WE, les théories du complot vont déjà bon train, spéculant sur une éventuelle découverte secrète pouvant potentiellement changer le cours de l’humanité que les mystérieux membres du Conseil d’Administration chercheraient à cacher… Pour votre information, ces fameux membres ne sont pas mystérieux (Who are the 4 directors of OpenAI’s board who fired Sam Altman?), et il n’y a pas eu de percée scientifique (Is an AGI breakthrough the cause of the OpenAI drama?), simplement des dizaines de milliards de dollars investis dans une toute petite structure pour accélérer le développement d’une technologie pas réellement mûre. Tous les ingrédients étaient réunis pour qu’OpenAI explose en vol, c’est maintenant chose faite.

Il nous reste maintenant à tirer les leçons de ce fiasco (l’innovation en marche forcée) et surtout à nous dépatouiller avec ce qui est présenté comme la plus grande avancée technologique du XXIe siècle, mais dont personne ne sait quoi faire tant les avis sont contradictoires : l’intelligence artificielle (soi-disant) généraliste.

Sommes-nous plus ou moins proches de l’achèvement de la première IA généraliste ? Je n’en ai aucune idée, mais je sais néanmoins qu’il y a un consensus sur la dangerosité des modèles génératifs et la nécessité d’en encadrer les usages : Une régulation souhaitable et nécessaire de l’intelligence artificielle.

Le débat autour des usages éthiques de l’intelligence artificielle est ainsi de plus en plus pressant (cf. Ethics of Artificial Intelligence de l’UNESCO) et pousse les gouvernements de grands pays d’Europe à réguler les innovations au plus vite (Germany, France and Italy reach agreement on future AI regulation), de préférence avant d’avoir atteint l’hypothétique cap de l’IA généraliste.

Ont-ils raison de légiférer au plus vite ? Je ne sais pas et eux non plus, car les choses se compliquent et les avis divergent (Effective accelerationism, doomers, decels, and how to flaunt your AI priors).

Que savons-nous sur l’intelligence artificielle généraliste (et sur l’intelligence) ? Pas grand chose…

Si nous avons une vague idée de ce qu’est l’intelligence artificielle (des systèmes capables d’effectuer des traitements cognitifs), personne n’est d’accord sur ce qu’est l’intelligence artificielle généraliste, ni si nous parviendrons un jour à la mettre au point tant le sujet est complexe : Why everyone seems to disagree on how to define Artificial General Intelligence.

La seule explication qui me semble intéressante est celle proposée par DeepMind : Here is how far we are to achieving AGI, according to DeepMind. La filiale dédiée à l’IA de Google décrit les IA généralistes comme des systèmes capables de rivaliser avec les humains selon une classification en 6 niveaux et deux approches : mono-tâche (Narrow) et multi-tâche (General).

Diriez-vous qu’une calculatrice est capable de rivaliser avec un humain ? Oui et non, car si une calculatrice ne se trompe jamais, contrairement aux humains, elle ne fait que calculer, contrairement aux humains. Ainsi, pour bien comprendre l’intelligence artificielle, ce qu’elle est ou n’est pas, si elle est plus intelligente que les humains ou pas, il faut s’intéresser à l’intelligence et ce qui rend les humains intelligents.

Je ne suis pas neurologue ni sociologue, mais je peux vous dire ce que nous savons :

- Ce qui différencie les humains des IA est leur volonté (la capacité de changer un cours d’actions, de contrôler les choses) et leur libre arbitre (la capacité à prendre des décisions de façon autonomes) ;

- Ces deux facultés sont acquises grâce à l’éducation (un ensemble de règles pour se comporter en société, de vivre en harmonie avec une conscience collective) et le capital culturel (l’ensemble des expériences vécues, les croyances et valeurs) ;

- L’acquisition de ces facultés est un processus long et empirique qu’il n’est pas possible d’accélérer (il faut une trentaine d’années pour qu’un embryon devienne un adulte raisonnable et responsable, qu’il dépasse la phase de l’adulescence) ;

- Ces acquis dictent nos comportements, de même que notre réaction aux stimuli externes (influencées par notre perception) et nos émotions (influencées par notre production hormonale) qui nous permettent de nous adapter aux différentes situations de la vie courante.

L’intelligence humaine est avant tout sociale et émotionnelle, pas compationnelle. Comprenez par là qu’un individu sera considéré comme intelligent ou capable d’assumer des responsabilités non pas grâce à ses facultés de calcul (pour ça, nous avons les calculatrices) ou de mémorisation (pour ça, nous avons les bases données), mais à sa capacité à écouter, à convaincre, à encadrer, à s’entourer des bonnes personnes…

Encore une fois, je ne suis ni neurologue, ni sociologue, ni ingénieur, mais j’essaye simplement de vous expliquer que les humains et les intelligences artificielles ne sont pas en compétition, car ces dernières sont incapables d’émuler l’intelligence sociale des humains. Les machines ne sont pas et ne seront jamais éduquées, elles ne vivront jamais d’expériences sociales, elles ne pensent pas, elles ne ressentent pas. Il est donc absurde de penser que des machines puissent se substituer à des humains, car ce ne sont pas des entités biologiques ou socialement intégrées.

Ce qui fait que les humains sont justement considérés comme des humains, et non des mammifères, c’est justement leur faculté à faire partie d’un collectif, ou plutôt de nombreux collectifs : les différents cercles sociaux au sein desquels nous interagissons (entreprises, associations, clubs de sport, cercles d’amis, partis politiques…). De ce point de vue, la distinction entre l’intelligence humaine et artificielle est évidente. Néanmoins, d’après cette autre définition de Wikipedia, un être humain est doué de la faculté de raisonner. Diriez-vous qu’une calculatrice sait raisonner ? Non, bien évidemment. Diriez-vous que ChatGPT sait raisonner ? C’est là où les choses se compliquent, car tout est question de perception et d’interprétation de la réalité.

Dans les faits, ChatGPT est capable de simuler un raisonnement de façon très troublante. Il est également capable de simuler l’intelligence de façon extrêmement convaincante. C’est par exemple ChatGPT qui a généré les explications ci-dessus sur l’intelligence sociale. Est-ce réellement de l’intelligence ou du raisonnement ? Nous ne savons pas. En revanche, il y a plusieurs choses que nous savons et qui méritent que l’on y accorde de l’importance.

Que savons-nous sur ChatGPT ? Pas grand-chose…

Le Conseil d’Administration d’OpenAI a-t-il eu raison de craindre que GPT échappe à tout contrôle ? Nous ne savons pas. L’intelligence artificielle est-elle un risque pour l’humanité ? Nous ne savons pas non plus, car il faut dans un premier temps définir le risque ainsi que le cadre d’utilisation de l’IA. C’est en substance la teneur de l’IA Act que l’Union Européenne est en train de finaliser. Le but de cette règlementation est de veiller à ce que les systèmes d’intelligence artificielle utilisés dans l’UE soient sûrs, transparents, traçables, non discriminatoires et respectueux de l’environnement (Proposition de cadre réglementaire sur l’intelligence artificielle).

ChatGPT est-il un système d’IA sûr et transparent ? Nous ne savons pas, car GPT-4 est une boite noire dont nous ne connaissons pas les caractéristiques détaillées. En revanche, nous savons que le modèle est constitué de plusieurs centaines de milliards de paramètres, donc quasi impossible à explorer ou à maitriser.

ChatGPT est-il traçable et discriminant ? Nous ne savons pas, car nous ne connaissons pas le corpus documentaire ayant servi à entrainer le modèle. En revanche, nous savons que ce corpus s’appuie sur des jeux de données open source issus du milieu universitaire (Common Crawl, The Pile, BookCorpus, Project Gutenberg…). Des data sets publics qui puisent allègrement dans des contenus sous licence, mais auquel on ne faisait pas attention, car ils servaient à des expériences scientifiques ou universitaires. Maintenant que nous avons des services payants (ex : ChatGPT Plus) auxquels sont abonnés des dizaines de millions de clients, les ayants droits se réveillent, ce qui engendre une bombe à retardement d’un point de vue juridique, car nous sommes dans la zone grise de la propriété intellectuelle et de la notion de “fair use” (plusieurs recours collectifs sont en train de se monter).

ChatGPT est-il respectueux de l’environnement ? Non, car nous savons délibérément que l’entrainement et les inférences de GPT consomment énormément d’énergie. C’est sur ce créneau que Meta espère tirer son épingle du jeu avec des modèles de taille variable permettant de tourner en local (sur un ordinateur ou un smartphone) pour faire baisser de façon drastique la consommation de bande passante et d’énergie (Llama 2 is about as factually accurate as GPT-4 for summaries and is 30X cheaper). Microsoft est également dans la course : Microsoft releases Orca 2, a pair of small language models that outperform larger counterparts.

Toutes ces raisons font que les membres du Conseil d’Administration d’OpenAI n’a eu d’autre choix que de licencier Sam Altman, non pas car ils ont eu peur d’un risque existentiel pour l’humanité, mais des risques bien réels causés par la mise sur le marché précipitée d’une offre dont on ne sait pas prédire l’évolution ou les usages.

Ceci nous amène à nous questionner sur la pertinence de la régulation et du modèle de société dans lequel nous voulons vivre (hé ouais !).

Quelle est la priorité de l’humanité : le statu quo ou l’évolution ?

Le psychodrame qui est en train de se jouer en Californie avec OpenAI peut se résumer en l’affrontement de deux courants de pensée, les techno-optimistes contre les techno-pessimistes, avec en toile de fond une problématique plus large : la survie de l’humanité (lire à ce sujet The Techno-Optimist Manifesto de Marc Andreessen)

Il y a d’un côté ceux qui pensent que l’innovation technologique va sauver l’humanité ; et de l’autre, ceux qui pensent qu’elle va au contraire la mener à sa perte. Je refuse catégoriquement de prendre position dans ce débat, car il est bien trop abstrait et surtout réducteur. Il y a ainsi un nombre infini de paramètres à prendre en compte pour… pour quoi déjà ? Faut-il réellement un débat pour comprendre que nous sommes arrivés au bout du système démocratique-capitaliste ? La réalité que nous avons du mal à admettre est que la démocratie parlementaire ne fait plus rêver personne (la victoire de Javier Milei en Argentine en est une nouvelle illustration) et que le capitalisme associé à la loi du marché ne profite réellement qu’à une minorité.

À partir de ce constat, doit-on impérativement oeuvrer pour tenter de maintenir une société qui craque dans tous les sens (permacrise) et dont nous savons qu’elle est de toute façon condamnée pour de simples raisons écologiques (successions de catastrophes naturelles) ? Bon OK j’avoue, ma question est rhétorique et ne fait pas avancer le débat sur l’IA… Néanmoins, ce débat sur l’intelligence artificielle trouve ses racines dans des considérations technologiques et juridiques, mais porte au final sur des questions sociales et politiques.

Je doute fortement que l’on puisse trouver des réponses satisfaisantes sur le plan macro-économique, car il y a trop d’intérêts contradictoires, mais que l’on peut agir à un niveau micro-économique, donc au niveau des entreprises et organisations. La question peut alors se résumer à : doit-on à tout prix défendre des outils et méthodes de travail hérités du XXe siècle ?

Là encore, ma question est rhétorique, mais j’ai deux convictions : d’une part, que nous ne pouvons pas rester passifs face aux changements en cours (nouvelle concurrence, nouvelles attentes des clients, nouvelles habitudes de travail…) ; et d’autre part, que les outils et méthodes de travail actuels sont inadaptés aux défis du XXIe siècle (Responsabilité numérique et régulation sont les conditions nécessaires à l’adoption des IA génératives en entreprise).

Les citoyens et salariés sont coincés entre une forte mécompréhension face à une soudaine “révolution” technologique qu’ils n’ont pas vue venir (les modèles génératifs), les scénarios catastrophes et la tentation de croire à un avenir meilleur porté par des IA bienveillants et serviles, celles qui vont nous soulager des tâches répétitives.

Plutôt que de spéculer sur les possibles utilisations détournées de l’IA, nous devrions plutôt nous préoccuper des utilisations détournées de l’outil informatique (emails, fichiers bureautiques…) et des outils numériques (logiciels en ligne, visioconférences…). C’est un réel problème qui grève la compétitivité des entreprises depuis trop longtemps et qui réduit leur marge de manoeuvre à une époque où la pression est très forte pour qu’elles se ré-inventent.

Je suis intimement persuadé que les entreprises et organisations ne pourront s’ancrer dans le XXIe siècle que quand elles auront opéré une réelle transformation : repenser les façons de créer de la valeur (modèles économiques), de travailler (modèles de collaboration), d’encadrer (modèles de management)… pour mieux s’adapter aux nouvelles conditions de marché.

Ainsi, les trois premières révolutions industrielles (celles du charbon, du pétrole et de l’électricité) ont permis aux entreprises de prospérer, mais elles nous ont surtout précipités dans l’impasse climatique / sociale / économique dans laquelle nous nous trouvons. La 4e révolution industrielle, celle du numérique, est censée projeter l’humanité dans le XXIe siècle, l’aider à trouver des solutions aux défis actuels, pas de l’aider à faire perdurer des modèles directement issus du siècle dernier.

Dans ce contexte et la nécessité d’opérer ce basculement (le Forum Economique Mondial parle de “Grande réinitialisation“), l’intelligence artificielle semble être le levier de progrès dont nous avons besoin pour tourner la page du XXe siècle et de façon très pragmatique nous extraire du paradigme des fichiers et des emails, une obsession personnelle que j’assume (Futur du travail : faut-il tuer l’email pour forcer l’adoption de la digitale workplace ?). L’IA va ainsi ouvrir une nouvelle ère pour l’informatique, pour les contenus / services numériques, et surtout redéfinir la société, de notre société (Everything you need to know about AI in 2023).

Vous êtes libres de penser qu’en accordant votre voix à tel ou tel leader populiste les choses vont changer, mais j’ai personnellement choisi mon camp : celui du progrès à travers ce qui est devenu le pilier de la civilisation, les outils et supports numériques (De la nécessité d’un nouveau contrat social pour homo numericus). À ce titre, je salue l’initiative d’Amazon qui affiche sa volonté de contribuer de façon active à cette quatrième révolution industrielle en proposant de former gratuitement le plus grand nombre à l’intelligence artificielle : Amazon aims to provide free AI skills training to 2 million people by 2025 with its new ‘AI Ready’ commitment.

Moralité : n’ayons pas peur des potentielles utilisations détournées de l’IA, mais prenons plutôt conscience des limites de nos usages actuels des outils informatiques et numériques, ainsi que des gains qui pourraient être potentiellement réalisés en acceptant de changer nos habitudes. De les changer de façon volontaire et non contrainte, de décider de nos futurs modes de vie et travail plutôt que de nous les faire imposer par manque de curiosité (découvrir de nouveaux usages) ou manque d’ambition (se contenter de ce que l’on a et s’en plaindre).