Alors que nous approchons du deuxième anniversaire du lancement de ChatGPT, se pose la question de l’évolution des chatbots. S’ils sont effectivement capables de prouesses aux yeux des néophytes, une analyse plus minutieuse des chatbots révèle de nombreuses limitations et surtout des freins à leur déploiement à grande échelle (plusieurs milliards d’utilisateurs réguliers). Une question que se sont posée les grands acteurs du numérique qui travaillent d’arrache-pied pour simplifier la création et la gestion de ce qui semble être l’évolution logique des chatbots (les agents intelligents) ainsi que le meilleur moyen de verrouiller le marché en contrôlant la demande (grâce aux assistants numériques intégrés).

En synthèse :

- Le succès apparent des chatbots masque un faible taux de rétention lié aux difficultés d’interagir avec eux à l’aide de prompts ;

- L’apprentissage du prompting semble superflu, mais il est indispensable pour comprendre la logique de programmation des agents intelligents ;

- Les agents intelligents sont l’évolution logique des chatbots, ils permettent l’exécution de tâches en s’appuyant sur des services et ressources externes ;

- Les assistants numériques intégrés bénéficient d’un énorme avantage sur les chatbots et agents intelligents (l’accès aux informations, ressources et applications) ;

- L’avènement des agents intelligents pilotés par les assistants numériques préfigure une nouvelle ère pour les applications d’entreprise.

Comme quasiment toutes les semaines depuis presque 2 ans, je continue de vous relayer les frasques d’OpenAI et des IA génératives. Cette semaine, il est question des statistiques de fréquentation du célèbre chatbot : ChatGPT Topped 3 Billion Visits in September.

Et comme à chaque fois, tout ce tapage médiatique amplifie l’illusion du miroir déformant. Certains continuent par exemple de proclamer que l’IA générative est la technologie à l’adoption la plus rapide de l’histoire de l’humanité, avec 40% de taux d’adoption en à peine deux ans : Generative AI adoption surpasses early PC and internet usage, study finds.

D’une part, il est trompeur de comparer la vitesse d’adoption de technologies payantes (ordinateur, connexion internet…) par rapport à un service gratuit ; d’autre part, de quoi parle-t-on au juste : de curieux qui essayent ChatGPT une fois ou d’utilisateurs qui conservent un abonnement payant au-delà de 3 mois ?

Adoption vs. Rétention

OpenAI revendique officiellement 200 M d’utilisateurs de ChatGPT : Americans are using AI at fairly high rates. What does this mean for the economy? Très bien, mais l’histoire ne dit pas si ce sont des utilisateurs réguliers ou des curieux qui se connectent une fois et abandonnent car ils n’ont pas le courage d’apprendre à prompter (et obtiennent donc des réponses non satisfaisantes à leurs demandes).

N’importe qui travaillant dans le numérique vous dira que l’important pour mesurer la popularité d’un service en ligne n’est pas le nombre de visiteurs, mais le taux de rétention : les utilisateurs qui se connectent plusieurs fois par semaine. L’article cité plus haut pointe ainsi du doigt le ratio nombre d’utilisateurs / taux de rétention de ChatGPT qui est largement inférieur à celui de services populaires comme Gmail, Instagram, WhatsApp, Tinder ou Duolingo : Why Meta & Google may win Consumer AI, before ChatGPT does.

L’auteur de l’analyse fait très justement remarquer que les chatbots qui sont censés rebattre les cartes sont encore loin derrière les services proposés par les géants numériques qui ont su s’implanter durablement dans le quotidien de milliards d’utilisateurs.

“The AI race is far from over, but the current advantage lies with the giants who already dominate our digital lives. They’re not just playing the game, they have home field advantage.”

Je n’ai de cesse depuis presque 2 ans d’essayer de vous faire prendre du recul par rapport à la frénésie ambiante, car je sais d’expérience qu’elle est néfaste à une adoption sereine de technologies qui vont assurément bouleverser notre quotidien, mais à terme (Du Web4 à la Société 5.0).

Comme j’ai déjà eu l’occasion de vous l’expliquer à maintes reprises : l’IA est un sujet complexe, qui peut potentiellement faire peur, pour lequel il y a un très fort besoin de pédagogie afin d’aider les futurs utilisateurs à en comprendre les points forts / faibles pour faciliter son adoption. Une adoption qui est pour le moment entravée par de nombreux mythes qui brouillent la compréhension de ce qu’est une IA et provoquent même un phénomène de rejet des modèles génératifs : Challenging The Myths of Generative AI.

« Before creating beneficial myths to direct our use of technologies, we first should understand the current myths surrounding artificial intelligence. Many seem obvious, but they continue to shape our thinking around AI. They infiltrate our thinking through convenience, as reliable shorthand, and as commonly understood references.

Il en résulte des signaux contradictoires et un déploiement de l’IA générative à grande échelle qui est au point mort, surtout dans des entreprises et organisations qui en ont pourtant désespérément besoin pour améliorer leur compétitivité. Mais ça n’empêche pas les vendeurs de rêve de continuer à spéculer sur l’IA généraliste : Decoding the Five Levels of OpenAI AGI Roadmap.

🤦🏻

Le mythe persistant de l’IA générale

D’après Wikipedia, une intelligence artificielle générale (« IAG » ou « AGI » an anglais) est une intelligence artificielle capable d’effectuer ou d’apprendre n’importe quelle tâche cognitive propre aux humains. N’importe quelle tâche ? Oui, en tout cas c’est ce qu’affirme le patron d’OpenAI qui persiste à essayer de nous faire croire que nous y sommes presque, du moins que sa société est sur le point de mettre au point la première super-intelligence collective, capable de faire basculer l’humanité dans une nouvelle ère : The Intelligence Age.

Des propos immédiatement relativisés par les observateurs avertis : Sam Altman catapults past founder mode into ‘god mode’ with latest AI post et No, Sam Altman, AI Won’t Solve All of Humanity’s Problems. Le discours ultra-optimiste du patron d’OpenAI est problématique, car l’utopie qu’il essaye de nous vendre ne correspond malheureusement à aucune réalité scientifique (il faudrait des avancées majeures qui ne sont pas encore faites), économique (son entreprise continue de perdre des milliards de $), ou sociétale (le grand public, les entreprises et les gouvernements ne sont pas prêts).

Si je suis convaincu que l’impact de l’IA sur notre société sera positif, sa généralisation devra se faire par paliers (pour éviter les catastrophes industrielles), selon un cadre strict (pour éviter les dérapages) et ne s’envisage que sur le moyen ou le long terme (pour éviter la concentration des richesses et pouvoirs sur un petit nombre d’éditeurs). Un déploiement progressif qui sera donc bénéfique, mais à terme, comme nous l’explique le CEO d’Anthropic (qui édite Claude, le grand rival de ChatGPT) : Machines of Loving Grace: How AI Could Transform the World for the Better.

Là où ça se complique, c’est quand d’autres sommités de l’IA donnent des avis divergents :

Qui a raison et qui a tort ? Difficile à dire, car ça dépend de l’IA, du modèle et des usages…

Des chatbots généralistes aux chatbots spécialisés

La bonne clé de compréhension de ce marché embryonnaire est de s’intéresser à ce que font les services d’IA générative et à qui ils sont destinés. Ainsi, les chatbots et outils reposant sur l’IA générative vont se répartir en 4 types d’offres :

- les chatbots à usages généraux (ex : ChatGPT, Claude…) que l’on peut comparer à des encyclopédies interactives, mais avec des capacités rédactionnelles ;

- les chatbots à usages sectoriels (ex : santé, banque, assurance…) que l’on peut considérer comme des experts synthétiques, avec une parfaite connaissance d’un secteur et des capacités analytiques ;

- les outils de création généralistes (ex : Midjourney, Runaway…) qui sont comme des baguettes magiques, capables de créer de très belles choses, mais que l’on ne peut pas réellement utiliser dans un contexte professionnel ;

- les suites applicatives spécifiques (ex : Hubspot pour le marketing , SalesForce pour la vente ou la relation-client, Firefly pour la communication et la publicité…) qui s’apparentent à des stagiaires synthétiques, une ressource bien pratique pour les tâches à faible valeur ajoutée, qui ne coûtent pas très cher, mais à qui il faut tout expliquer.

Ce à quoi nous sommes en train d’assister en ce moment est une professionnalisation des chatbots et outils de création qui se spécialisent dans un secteur ou un métier.

À court terme, le scénario d’évolution le plus probable, qui est d’ailleurs en train de se réaliser, est une transformation de démonstrateurs techniques en produits destinés aux entreprises. Une évolution logique, qui se passe plutôt bien, car nous voyons émerger des services très intéressants, mais qui ne règlent pas le problème de prise en main : la difficulté d’apprendre à prompter.

Certains semblent ignorer cette difficulté, mais Apple n’est pas dupe : c’est un mode d’interaction contre-intuitif, un réel obstacle à l’adoption par le plus grand nombre, voilà pourquoi il n’y a pas de prompts dans la future Apple Intelligence (L’IA est un concept, pas un produit).

Heureusement, d’autres éditeurs apportent un début de réponse, notamment dans le BtoB pour les PME et TPE avec des services comme l’assistant facturation de Boby destiné aux artisans (que l’on sollicite via des messages textuels ou vocaux sur WhatsApp), ou comme Pulse disponible dans la suite Cegid.

En s’inspirant de cet exemple, on en vient à se demander s’il est pertinent d’apprendre à prompter. Si effectivement je suis convaincu que les chatbots ne sont qu’une étape vers les assistants numériques, apprendre à prompter permet de mieux comprendre le fonctionnement des modèles génératifs et surtout de se préparer à la prochaine étape.

Des chatbots spécialisés aux agents intelligents

Mettez un utilisateur lambda devant ChatGPT sans formation ou explications et il ne vous faudra pas plus de 5 minutes pour comprendre que les chatbots tels qu’ils existent aujourd’hui sont une impasse, car leur manipulation à l’aide de prompts requiert un effort que très peu sont prêts à fournir.

De plus, les chatbots sont limités, car ils sont coincés dans la fenêtre du navigateur, et ils y resteront (Google, Microsoft et Apple y veilleront). Comprenez par là que s’ils peuvent produire ou manipuler des contenus avec brio, leur champ d’action se limite à des réponses aux questions posées par les utilisateurs. Vous pourriez me dire que non, car les chatbots sont capables de générer du code pour créer des sites web ou de petites applications en ligne, mais ils restent tributaires des questions ou prompts des utilisateurs.

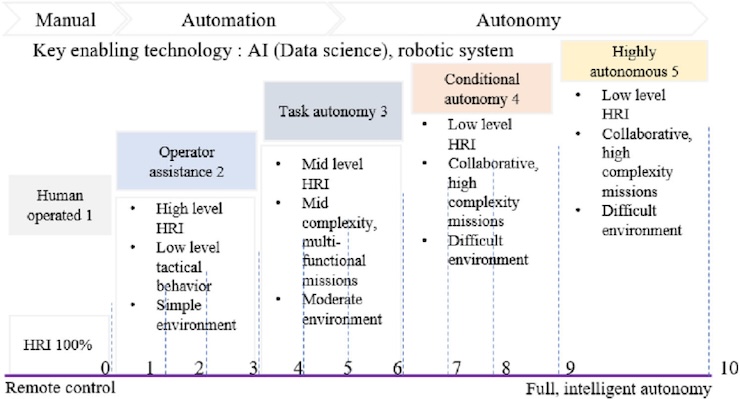

Ce dont ont besoin les chatbots pour conquérir un plus grand nombre d’utilisateurs est de pouvoir agir en dehors de la fenêtre du navigateur et surtout de façon autonome. Pour faire simple : des mini-programmes qui exécuteront des tâches à la place des utilisateurs. C’est ce que l’on appelle les agents intelligents, l’évolution logique des chatbots pré-configurés (les Custom GPTs d’OpenAI, Gems de Google ou Copilots de Microsoft).

Le principe sous-jacent aux agents intelligents n’est pas de générer une réponse textuelle, mais de décomposer une demande en tâches qui sont confiées à des agents spécialisés. C’est le principe proposé par l’éditeur de ChatGPT qui est déjà en train de préparer l’évolution de son service : OpenAI introduces experimental multi-agent framework « Swarm”.

Dans l’exemple ci-dessus, la demande est simple, donc l’effort demandé à l’utilisateur est minime. Mais pour des tâches plus complexes, l’apprentissage du prompt est indéniablement un gros avantage, car cela permet à l’utilisateur de correctement spécifier son besoin (objectif, contexte, contraintes, étapes de réalisation…) à l’aide d’instruction en langage naturelle. Formulé autrement : apprendre à prompter, c’est apprendre à programmer des agents intelligents.

Le principal avantage des agents intelligents est de pouvoir réaliser des tâches sur des sites ou services externes (chercher une information, rapatrier une donnée, passer une commande…), et même de le faire de façon asynchrone. Nous pouvons ainsi envisager des services de création d’agents intelligents proposant des agents pré-configurés qu’il suffirait de paramétrer en fonction d’un contexte ou d’une tâche précise.

Il y a quelques années, cette promesse était formulée par les éditeurs de solution « no-code » qui proposaient de créer des sites web ou applications en ligne sans savoir coder. Ces solutions no-code se sont révélées particulièrement utiles pendant la pandémie pour créer des mini-sites ou applications dans l’urgence et pouvoir assurer une continuité d’activité (Le no-code pour s’adapter plus vite dans un environnement post-COVID). Mais depuis, l’engouement est retombé, car le côté jetable de ces applications semble être dissuasif.

Nous sommes bientôt en 2025, et en cette période de poly-permacrise il semble à nouveau urgent de pouvoir gagner du temps et d’acquérir de l’autonomie pour pouvoir faire face aux nombreux aléas du marché. D’où le recours aux agents intelligents qui vont nous permettre de faire plus avec moins en leur déléguant des tâches répétitives et/ou à faible valeur ajoutée : Gen AI is Passé, Enter the Age of Agentic AI.

« Agentic AI is the next level of artificiel intelligence designed to pursue goals with human supervision by accomplishing work and invoking tools. Agentic AI uses generative AI but goes further than a system of requet and response. Agents make a plan to perform work on a user’s behalf given a goal. In addition, an agent can work in concert with other agents managed by a supervising agent that can orchestrate interactions between agents ».

Le Saint-Graal étant de pouvoir combiner les agents, ou même de les laisser s’organiser entre eux.

Vous remarquerez que ces dernières semaines le discours des éditeurs de solutions reposant sur l’IA a évolué et que la bataille sémantique s’est clairement déportée des chatbots et LLMS vers les agents intelligents. Ces derniers nous étant présentés comme l’évolution logique des pratiques de Robotic Process Automation : Beyond Bots: How AI Agents Are Driving the Next Wave of Enterprise Automation.

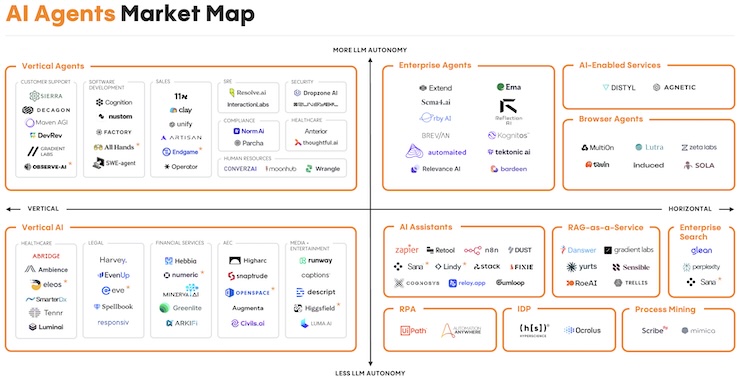

Selon cette évolution, nous ne parlons plus de modèles de langage (« LLM » pour « Large Language Model« ), mais de modèles d’action (« LAM » pour « Large Action Model« ). Le marché des chatbots étant préempté par ChatGPT, Claude ou Perplexity, un nouveau marché est déjà en train de se structurer autour d’agents spécialisés et des services de création / gestion d’agents.

De nombreuses startups se précipitent logiquement sur ce nouveau créneau, mais se heurtent à la difficulté d’intégration, c’est-à-dire la gestion des accès accordés aux agents pour pouvoir exploiter des services externes. En tenant compte de cette limitation, les acteurs historiques du marché du RPA comme Zappier, UIPath ou IFTTT disposent d’une bonne longueur d’avance.

Et si l’on doit prendre en compte l’accès aux applications internes, là ça se complique carrément et le choix se limite aux grands acteurs. SalesForce nous a ainsi dévoilé sa nouvelle offre le mois dernier (AgentForce: Customizable AI Agent Builder), et c’est maintenant Oracle qui présente la sienne : Oracle AI Agents Help Organizations Achieve New Levels of Productivity.

L’important ici n’est pas d’avoir les agents intelligents les plus performants ou simples à configurer, mais d’avoir une plateforme d’agents qui soit intégrée aux environnements de travail. Et à ce sujet, ce sont les acteurs historiques qui finiront forcément par avoir le dernier mot.

Des agents intelligents aux assistants numériques

J’ai déjà eu l’occasion de vous décrire dans un précédent article mes convictions sur l’évolution du marché des services reposant sur l’IA générative avec une (plus que) probable domination des assistants numériques : Les agents intelligents sont les nouveaux chatbots.

Selon moi, il existe de nettes différences entre les chatbots, les agents intelligents et les assistants numériques, notamment la persistance et le rayon d’action :

- les chatbots sont cantonnés à la fenêtre du navigateur (ils sont souvent bloqués par les sites et services externes) et s’arrêtent de fonctionner dès qu’on ferme la fenêtre ;

- les agents intelligents qui sont des mini-programmes utilisés pour exécuter des tâches en s’appuyant sur des services ou ressources externes (mais qui ne bénéficient pas forcément de toutes les autorisations d’accès) ;

- les assistants numériques qui n’ont aucun problème d’accès et sont capables de piloter d’autres agents.

Comme le dit le proverbe : « Integration beats distribution« . Les assistants numériques bénéficient ainsi d’un énorme avantage : être directement intégré au système d’exploitation (Windows pour Copilot, Android et ChromeOS pour Gemini, iOS et MacOS pour Siri) ou à l’environnement de travail (Microsoft365 et Teams pour Copilot, Workspace pour Gemini, Workday pour Illuminate, Notion pour AI Companion …).

Cette intégration native permet aux assistants numériques d’avoir accès à toutes les informations, données et fonctionnalités nécessaires à l’exécution des tâches demandées par les utilisateurs. Nous pouvons tout à fait envisager un futur très proche (quelques mois) où il suffira d’énoncer votre besoin pour que celui-ci soit prit en charge par l’assistant de votre ordinateur, smartphone ou environnement de travail.

Non, ceci n’est pas de la science-fiction ou un autre vaporware, car les équipes de Microsoft, Google ou Apple y travaillent d’arrache-pied, comme le prouve cette récente publication : Apple’s local AI agent framework paves the way for more useful Apple Intelligence. Dans cet exemple, Siri collecterait la demande et créerait un agent pour l’exécuter en s’appuyant sur des permissions dont lui seul bénéficie (l’accès aux applications et ressources du système).

Nombreux sont ceux qui aujourd’hui nous promettent monts et merveilles, notamment des gains de productivité significatifs grâce à l’IA générative, mais ils ne sont visiblement pas au fait des limitations des chatbots. La vérité est que à court terme, seuls ceux qui maîtriseront les agents intelligents (qui seront capables de les créer grâce à des prompts) pourront gagner en productivité, pas les autres (ceux qui se contentent de prompter comme ils font des recherches sur Google). Voilà pourquoi il est primordial d’apprendre à prompter.

Les observateurs avertis me feront remarquer que nous avions déjà à disposition les solutions no-code pour pouvoir créer des simili agents (ex : PowerApps de Microsoft ou AppSheet de Google), mais ces solutions requièrent une rigueur dans l’approche qui semble hors de portée des utilisateurs lambda. Heureusement, les progrès réalisés en reconnaissance du langage et en capacités de raisonnement des modèles génératifs me laissent penser que nous allons très prochainement abaisser les barrières à l’entrée et envisager à nouveau le principe de système d’information à la carte.

L’avènement des agents intelligents pourrait potentiellement redonner de l’autonomie aux utilisateurs et permettre de lutter contre le problème de la fragmentation des systèmes d’information avec la possibilité d’utiliser les agents intelligents pour faire le pont entre les bases de données / connaissances et les applications : How agentic AI platforms will redefine enterprise applications.

Loin de moi l’idée de me perdre en conjecture et de faire des promesses équivalentes à celles que je dénonce en début d’article, mais force est de constater que nous sommes sur le bon chemin, celui du progrès (pour contre-balancer les utilisations détournées des modèles génératifs comme les arnaques au deep fake).

Toujours est-il qu’en démocratisant la création et la gestion d’agents intelligents à travers les assistants numériques, nous entrons dans une nouvelle phase de croissance avec l’émergence de nombreuses startups proposant des agents verticaux ou horizontaux : The agent economy.

The public cloud unleashed the SaaS economy. The iPhone ushered in the app economy. Social media enabled the creator economy. Recent AI innovations mark a similar tectonic shift, and we are now entering the era of the agent economy.

Pour conclure cet article, je me sens obligé de préciser que nous ne parviendrons pas à basculer dans cette nouvelle ère des agents intelligents tant que nous n’aurons pas pris conscience des limitations des chatbots actuels ainsi que de la difficulté que représente l’apprentissage du prompt pour les utilisateurs lambda. Comme toujours, l’important n’est pas de chercher à leur apprendre, mais de leur donner envie d’apprendre, ce qui passe nécessairement par une phase d’acculturation pour pouvoir leur faire comprendre les enjeux de l’IA et combler une dette numérique qui se creuse à mesure que les usages et technologies évoluent.