À peine deux ans après la sortie de ChatGPT, le marché commence déjà à montrer des signes d’essoufflement pour les chatbots et à chercher la prochaine « Next Big Thing » pour stimuler l’adoption de l’IA générative. Inutile de chercher bien loin, car un consensus est en train d’émerger autour des agents intelligents, la nouvelle poule aux oeufs d’or des ESN et cabinets de conseil en technologies. Sommes-nous en train d’assister à l’avènement des agents autonomes et d’un web « agentisés » ? Oui et non, car si les éditeurs mobilisent toutes leurs ressources pour essayer de prendre de vitesse la concurrence, les utilisateurs lambda sont très TRÉS loin d’être prêts pour ce scénario.

En synthèse :

- L’enthousiasme initial autour de ChatGPT montrant des signes d’essoufflement, les éditeurs cherchent de nouveaux moyens de stimuler la demande pour l’IA générative ;

- L’adoption des solutions d’IA reposant sur les chatbots ralentis nettement, car les performances des modèles génératifs stagnent du fait d’un manque de données d’entraînement complémentaires ;

- Les éditeurs sont en train d’étoffer leur offre et de réorienter leurs discours autour des agents intelligents offrant plus de possibilités que les chatbots ;

- Plutôt que de parler d’agents intelligents, nous devrions utiliser le terme « agents autonomes », car ils ne sont pas vraiment intelligents, mais peuvent agir en autonomie ;

- Les perspectives d’adoption des agents autonomes sont pour le moment réduites du fait du manque de compétences pour les concevoir et les développer, en attendant que les assistants numériques soient capables de le faire pour le compte des utilisateurs.

Prédire où va le marché de l’IA dans les prochaines années n’est pas très compliqué (Les scénarios d’adoption de l’IA générative pour 2025 et après). En revanche, anticiper les 3 à 6 prochains mois est beaucoup plus dure. Surtout avec un rythme d’innovation très élevé (des nouveautés toutes les semaines) et beaucoup d’instabilité (nouvelles règlementations, tensions internationales sur la production de composants, disponibilité des matières premières…).

La seule certitude que nous ayons est que ChatGPT est l’arbre qui cache la forêt : Visualizing ChatGPT’s Rising Dominance.

Outre le succès de ChatGPT, une analyse du marché un tant soit peu sérieuse révèle que les chatbots ne peuvent pas servir à tout et en toutes occasions. Deux visions s’opposent : les ultra-optimistes (pour qui les chatbots sont la solution à tout) et les pragmatiques (qui attendent des bénéfices concrets). Un dialogue compliqué, car chacun voit dans l’IA un verre à moitié vide ou à moitié plein.

Ce qui est certain, c’est que l’enthousiasme initial pour les chatbots est en train de s’essouffler.

La fin du conte de fée pour les chatbots

Je pense ne rien vous apprendre en écrivant que le marché s’est clairement emballé pour les chatbots depuis la sortie de ChatGPT, un emballement à la limite du raisonnable. Voilà presque 2 ans que le grand public a découvert ce service, et même si la couverture médiatique dont il bénéficie est remarquable, nous commençons très clairement à voir les limites des chatbots grand public (hallucinations, prise en main…). Et ce n’est pas un changement d’URL qui va changer la donne (OpenAI acquired Chat.com for 15,5 M$).

Première illustration de cet état de fait avec cette étude sur l’utilisation des chatbots dans le commerce en ligne : Generative AI’s Potential to Improve Customer Experience. Les consommateurs sont, à juste titre, plutôt attentistes via-à-vis des chatbots et autres fonctionnalité proposées par l’IA générative : la moitié déclarent se satisfaire des boutiques en ligne actuelles. J’imagine qu’ils préfèrent avoir la livraison gratuite…

Autre illustration avec la dernière édition de l’étude Workforce Index de Slack où l’on nous confirme que si l’adoption de l’IA dans l’environnement de travail est très majoritairement envisagée (99% pour les managers et 76% pour les employés), il y a tout de même des freins à la fois pédagogiques (nécessité de former) et psychologiques : The Fall 2024 Workforce Index Shows Executives and Employees Investing in AI, but Uncertainty Holding Back Adoption.

Les principales raisons invoquées pour la non-utilisation des chatbots sont ainsi les suivantes :

- 47% des sondés pensent qu’utiliser l’IA équivaut à tricher ;

- 46% ont peur de passer pour des incompétents ;

- 46% craignent d’être vue comme des fainéants.

Si vous ne deviez retenir qu’une seule statistique de cette étude, c’est la suivante : la part des salariés enthousiastes sur l’IA est passée de 53% à 41% en un an. Ceci explique la stagnation dans l’adoption constatée aussi bien aux États-Unis qu’en France.

Dernière illustration avec la troisième édition du Baromètre Data Publica réalisé par Banque des Territoires, La Poste et Orange : l’IA s’impose dans les collectivités, mais les citoyens sont encore méfiants. Cette étude nous révèle que la méfiance de l’IA prend clairement le pas sur la curiosité.

Dans cette autre question sur l’utilisation de l’IA pour les services publics de proximité, on apprend que 4/5 des Français préfèrent attendre de parler à un agent au guichet plutôt qu’à un chatbot disponible en continu.

Pour résumer une longue histoire : les récits autour des bienfaits miraculeux de l’IA générative s’essoufflent, les utilisateurs veulent des bénéfices concrets, pas des promesses.

Des modèles qui stagnent par manque de données fraiches

Face à cette désillusion grandissante vis-à-vis des chatbots, comment stimuler l’adoption de l’IA générative ? Tout simplement en fournissant de meilleures réponses aux utilisateurs. Sauf que la très large majorité des utilisateurs se sert des chatbots comme des moteurs de recherche : ils saisissent une courte demande et espèrent une réponse pertinente. Le problème est que les modèles de langage ne fonctionnent pas comme les index des moteurs de recherche : il faut des demandes précises et structurées pour obtenir des réponses pertinentes. Problème : l’apprentissage du prompt est une démarche laborieuse et intimidante pour les utilisateurs lambda qui n’ont aucune culture informatique. Car quoi que vous en pensiez : prompter, c’est programmer. Certes, il n »y a pas de syntaxe à assimiler, car tout se fait en langage naturel, mais la structure des prompts doit être rigoureuse pour améliorer la qualité des réponses, et les techniques avancées de prompting semblent très clairement hors de portée du grand public.

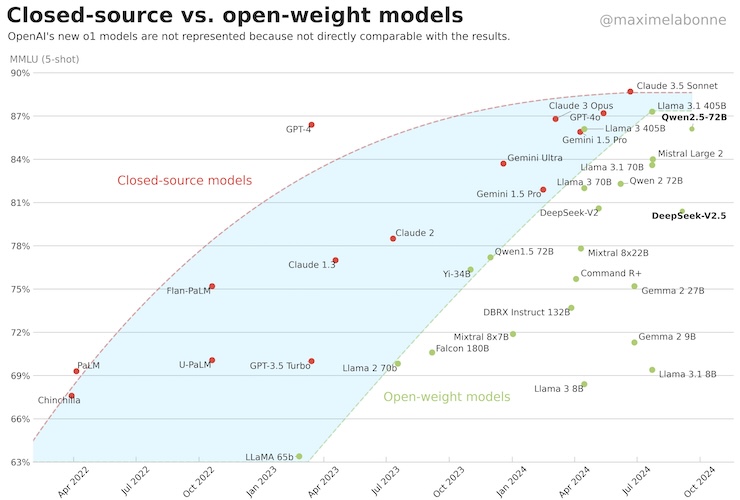

La solution à cette limitation serait de concevoir des modèles encore plus puissants (avec des meilleures capacités de compréhension des besoins des utilisateurs), sauf que les gains de performances qui devaient être exponentiels sont en fait logarithmiques : les éditeurs décalent la sortie de leurs prochains modèles, car la progression n’est pas suffisante (OpenAI, Google and Anthropic Are Struggling to Build More Advanced AI).

L’origine du problème est toute simple : nous avons déjà utilisé toutes les données d’entrainement disponibles (les définitions de Wikipedia, les articles de blog, les discussions des forums, les actualités, les livres tombés dans le domaine public, les retranscriptions des vidéos YouTube…). N’espérez donc pas de gains de performances sans la mise à disposition d’un volume significative de nouvelles données d’entrainement. Et non, n’allez pas croire que les données synthétiques sont une solution de contournement viable, car leur utilisation à grande échelle est risquée (AI models collapse when trained on recursively generated data).

L’autre solution pour relancer l’intérêt du grand public n’est pas de proposer des IA plus puissantes, mais plus utiles. Nous passons donc de la quête d’une IA surpuissante et omnisciente (la fameuse IA généraliste), à des services complémentaires associés aux chatbots.

La stratégie d’acquisition de nouveaux utilisateurs d’éditeurs comme Perplexity repose ainsi sur de nombreuses fonctionnalités (ex : pages thématiques, espaces de collaboration, résultats d’élection…) et plus récemment sur l’achat intégré : Perplexity introduces a shopping feature for Pro users in the U.S.

D’autres éditeurs voient plus loin comme Microsoft, Google, OpenAI ou Anthropic et anticipent la prochaine étape. En quelques semaines, le marché a ainsi opéré un pivot pour focaliser son attention non plus sur les chatbots, mais sur les agents intelligents.

Chatbots vs Agents intelligents vs Assistants numériques

Dans la plus pure tradition de la Silicon Valley (un clou chasse l’autre), une innovation en éclipse une autre. Ainsi, nous n’avons même pas fêté l’anniversaire du lancement de ChatGPT que les « experts en IA » se sont trouvé une nouvelle marotte. Il suffit de faire faire défiler les publications récentes sur LinkedIn pour vous convaincre que les agents intelligents sont la nouvelle poule aux oeufs d’or. Et comme toujours pour respecter la tradition, personne ne prend le temps de définir ce que c’est ou n’est pas…

Selon la définition, un agent est une personne ou une entité qui agit (par opposition au patient qui subit l’action). Donc par analogie : “Un agent intelligent est un système informatique capable de percevoir son environnement, d’analyser des données, de prendre des décisions et d’agir de manière autonome pour atteindre des objectifs prédéfinis”.

Un agent intelligent fonctionne en quatre temps :

- Perception (collecte de données depuis l’environnement via des capteurs ou des interfaces) ;

- Analyse (traitement et interprétation des données pour comprendre la situation actuelle) ;

- Décision (sélection de l’action optimale à entreprendre pour atteindre les objectifs fixés) ;

- Action (exécution de l’action choisie dans l’environnement).

Les plus répandus sont les agents de recherche et les agents de veille (cf. What exactly is an AI agent?).

Quelle différence entre les chatbots, les agents intelligents et les assistants numériques ? J’ai déjà abordé le sujet (Les agents intelligents sont les nouveaux chatbots), mais je vous en propose une explication simplifiée :

- Les chatbots discutent, ils fournissent des réponses à des questions, mais si vous ne formulez pas de questions, ils ne font rien (ex : ChatGPT, Claude…) ;

- Les agents agissent en dehors de la fenêtre du navigateur, ce sont des programmes autonomes qui sont activés à intervalles réguliers ou par des événements prédéfinis (ex : AutoGPT, AgentGPT, BabyAGI…).

- Les assistants numériques assistent dans la réalisation de tâches à l’aide d’agents, ils sont intégrés au système d’exploitation de votre ordinateur ou de votre smartphone et peuvent faire des recherches dans vos emails, fichiers ou agenda, ouvrir et exploiter vos applications… (ex : Gemini, Copilot, Siri…).

Comme vous pouvez le constater, il y a bien une hiérarchie entre les chatbots, les agents et les assistants en fonction de là où ils résident et de leur champ d’action. En bas de la pyramide, on trouve les chatbots qui sont des services en ligne que les utilisateurs vont solliciter de temps en temps. En haut de la pyramide, on trouve les assistants numériques qui sont intégrés au système d’exploitation des terminaux (ordinateurs, smartphones, tablettes…) et tournent en permanence. Entre le bas et le haut de la pyramide, on trouve les agents intelligents qui sont hébergés dans la cloud ou sur le terminal, là où ils peuvent être en veille.

Comme expliquer plus haut, le soufflet des chatbots étant retombé, les éditeurs redoublent d’efforts pour prendre la concurrence de vitesse sur le terrain des agents :

Je pense que vous n’avez pas besoin de plus de liens pour bien appréhender la tendance et comprendre que dans les six prochains mois, tous les regards vont se tourner vers les agents intelligents qui semblent offrir des perspectives concrètes immédiates. Le secteur de l’IA étant en pleine ébullition, il ne faudra pas longtemps à l’ensemble des acteurs pour opérer un changement de cap vers les agents intelligents…

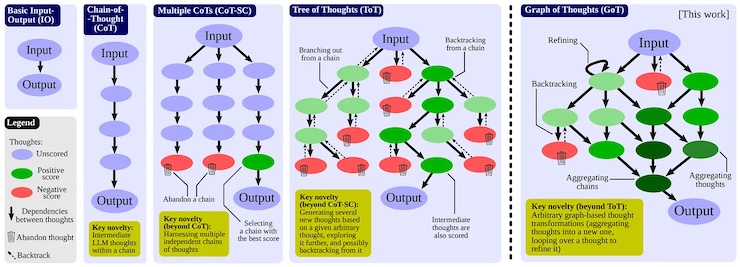

Le B-A-BA des agents (soit-disant) intelligents

Avant de me lancer dans une explication sur les différentes façons de concevoir un agent, commençons par poser LA question : Les agents intelligents sont-ils réellement intelligents ? Non, car ce sont simplement des programmes informatiques. La principale qualité que l’on doit leur prêter n’est pas l’intelligence, mais plutôt l’autonomie, c’est-à-dire la capacité de réaliser des tâches de façon autonome pour le compte des utilisateurs.

Les agents intelligents autonomes sont-ils capables de tout faire ? Oui bien entendu, au même titre qu’un programme informatique. Le tout étant de les programmer correctement, et c’est là toute la difficulté, car les personnes capables de programmer des agents autonomes ne représentent qu’une infime partie de la population : les informaticiens et développeurs en herbe.

Si nous mettons de côté la population informatique qui dispose de ses propres outils pour développer de agents (A busy person’s Intro to AI Agents), il y a grosso modo deux façons de concevoir des agents autonomes sans avoir à coder : par mimétisme, et grâce à des instructions en langage naturel.

Si nous prenons l’approche par mimétisme, certains agents sont maintenant capables de reproduire les gestes des utilisateurs. C’est le principe que proposent des éditeurs comme Adept, mais également celui adopté par l’éditeur du chatbot Claude qui a rajouté à son tout dernier modèle une couche d’exécution (« action-execution layer ») pour pouvoir reproduire les manipulations des utilisateurs : Anthropic’s new AI model can control your PC.

L’éditeur de ChatGPT a visiblement opté pour une autre approche, puisque les équipes seraient en train de finaliser un cadre logiciel permettant aux utilisateurs de créer des agents (des « opérateurs ») qui exploiteraient la dernière version du modèle GTP pour pouvoir réaliser des tâches via un navigateur : OpenAI’s next product could book flights and more by taking over your PC.

Nous ne savons pas grand-chose de ce projet, uniquement des rumeurs, mais ce qui est certain, c’est que nous sommes en train d‘assister à une ruée vers le desktop, car tous les éditeurs proposent maintenant un logiciel à installer (OpenAI, Anthropic et même Perplexity). Le but de la manoeuvre étant de mettre un pied sur l’ordinateur des utilisateurs (littéralement) pour pouvoir s’extraire de la fenêtre du navigateur et proposer des services de plus haut niveau.

Est-ce là le modèle gagnant pour les éditeurs indépendants ? Malheureusement non, car les ressources système (applications, fichiers…) sont la chasse gardée de Apple ou Microsoft qui voient d’un très mauvais oeil ces nouveaux entrants leur marcher sur les plates-bandes (respectivement Siri et Copilot). Attendez-vous à ce que de nouvelles restrictions soient mises en place dans les prochaines mises à jour pour justement restreindre les possibilités de ces applications.

Si l’accès aux ordinateurs est bloqué par Apple et Microsoft, rien n’empêche les agents d’opérer dans le cloud, mais cela nécessite une infrastructure spécifique pour les créer, les gérer et surtout les faire tourner : The Rise of AI Agent Infrastructure.

C’est sur ce principe que les éditeurs d’outils d’automation sont en train de repositionner leur plateforme pour en faire des environnements de création et d’exécution d’agents à travers une interface no-code (ex : Zapier, Make, Relay, CrewAI, n8n…).

Si vous pensiez que les agents autonomes allaient signer la fin des services d’automation, c’étaient sans compter sur la promptitude des éditeurs à intégrer l’IA pour faire évoluer leur offre (cf. RIP to RPA: The Rise of Intelligent Automation).

Là encore, c’est tout l’écosystème des solutions d’automation, qui est en train de se reconfigurer autour des agents avec de nombreuses solutions de low-code (ex : FlowiseAI, AgentQL…) et même des briques de paiement à intégrer en quelques clics : Adding payments to your LLM agentic workflows

D’autres services proposent déjà des agents pré-configurés pour faire de la recherche / extraction d’informations comme Browse.ai. Sinon, il y a bien évidemment les solutions proposées par les BigTechs : Power Automate, Copilot Actions ou Copilot Studio de Microsoft, Vertex AI Agent Builder ou AppSheet Automation pour Google.

Enfin, toujours dans cette dynamique de refonte des discours de marque, les fabricants de processeurs qui intégraient auparavant des unités de traitement neurales pour faire tourner des modèles en local, proposent maintenant d’intégrer des composants pour faire tourner des agents autonomes en local : MediaTek Targets the ‘Agentic AI Era’ With Dimensity’s Next Evolution.

Ces nouvelles architectures matérielles sont-elles révolutionnaires ? Non absolument pas, c’est rigoureusement la même chose qu’avant (des unités de traitement neurales ou « Neural Processing Units« , NPUs), seul le discours à changer (les termes employés. Toute l’industrie est donc en train de se reconfigurer autour des agents autonomes, il ne reste plus qu’à attendre que les utilisateurs s’y mettent…

Qui va créer les agents ? Les informaticiens, donc toujours un problème de maturité numérique…

Nous assistons donc à la naissance du web agentisé (The Agentic Web) et les possibilités sont nombreuses, notamment pour ce qui est de la monétisation : The 4 Business Models of Consumer AI Agents.

OK très bien, mais qui est aujourd’hui concrètement en mesure de concevoir, développer et gérer tous ces agents ? Pas grand monde en dehors des équipes informatiques. Ainsi, les solutions pour développer des agents autonomes sont de plus en plus robustes et efficaces (ex : LangChain, Vellum, Galileo, HoneyHive…), mais ces derniers sont exposés à une obsolescence très rapide (leur durée de vie n’excède pas 6 mois), ce qui va engendrer une forte tension sur le marché des développeurs d’agents.

Nous allons immanquablement nous retrouver dans la même situation qu’il y a 15 ans avec le boom des applications mobiles : tout le monde voulait développer sa propre application, mais les ressources étaient très limitées. Avec les agents autonomes, le goulot d’étranglement est le même : la disponibilité des équipes informatiques.

Tout ceci nous ramène à la case départ et à la difficulté rencontrée par les entreprises lors du déploiement à grande échelle de l’IA générative : former les collaborateurs au prompt est un chantier long et couteux.

Dans la mesure où nous ne pouvons décemment pas espérer que les DSI des grandes entreprises vont subitement trouver de la place dans leur feuille de route de développements, nous pouvons éventuellement envisager une solution intermédiaire où des “référents IA” pourraient créer des agents à la place des utilisateurs. Ces référents internes seraient l’évolution logique des “référents numériques” qui étaient chargés d’assister et d’accompagner les salariés dans leur appropriation des usages et technologies numériques. Ce chantier reste toujours d’actualité, mais il y a visiblement urgence à déployer l’IA…

Au final, nous sommes encore et toujours confrontés au problème récurrent de maturité numérique. Le facteur limitant dans l’adoption de l’IA en entreprise (à travers les chatbots ou les agents) n’est pas de nature technique, mais culturelle : sans culture numérique, il n’y a que très peu de chance pour que les salariés lambda se prennent de passion pour les IA et se mettent à s’auto-former pendant leur temps libre.

D’où l’importance d’initiatives d’acculturation numérique, mais ça vous le saviez déjà, non ?