Ollama vous permet d’exécuter divers grands modèles de langage (LLM) sur un serveur privé ou une machine locale afin de créer un agent d’IA personnel. Par exemple, vous pouvez le configurer avec DeepSeek R1, un modèle d’IA très populaire connu pour sa précision et son prix abordable.

Dans cet article, nous allons expliquer comment faire fonctionner DeepSeek R1 avec Ollama. Nous vous guiderons à travers les étapes de l’installation de la plateforme jusqu’à la configuration des paramètres de chat pour votre cas d’utilisation.

Conditions préalables

Avant d’installer Ollama, assurez-vous que vous disposez d’une plateforme VPS Linux, que nous utiliserons pour héberger l’agent AI. Si vous souhaitez l’installer en local, vous pouvez utiliser votre ordinateur personnel Linux.

Quoi qu’il en soit, votre système doit répondre aux exigences matérielles minimales. Les plateformes d’IA comme Ollama étant gourmandes en ressources, il vous faut au moins :

- 16 Go de RAM

- 12 Go d’espace de stockage

- 4 cœurs de CPU

Pour le système d’exploitation, vous pouvez utiliser des distributions Linux populaires comme Ubuntu et CentOS. Il est important d’utiliser la version la plus récente pour éviter les problèmes de compatibilité et de sécurité.

Si vous ne disposez pas d’un système répondant aux exigences, achetez-en un chez Hostinger. À partir de €8.99/mois, notre plan KVM 4 offre 4 cœurs de CPU, 16 Go de RAM et 200 Go de stockage SSD NVMe.

Notre VPS dispose également de plusieurs templates de systèmes d’exploitation qui vous permettent d’installer des applications en un seul clic, y compris Ollama. Cela rend le processus d’installation plus rapide et plus convivial pour les débutants.

En outre, Hostinger VPS dispose de l’assistant IA Kodee intégré qui peut vous aider à résoudre les problèmes ou vous guider dans la gestion de votre serveur. À l’aide d’invites, vous pouvez lui demander de vérifier votre système ou de générer des commandes pour divers besoins.

Après vous être assuré que vous remplissez les conditions préalables, suivez les étapes suivantes pour installer Ollama sur un système Linux.

1. Installer Ollama

Les utilisateurs d’Hostinger peuvent facilement installer Ollama en sélectionnant le template correspondant lors de l’onboarding ou dans le menu Système d’exploitation de hPanel.

Sinon, vous devez utiliser des commandes. Pour commencer, connectez-vous à votre serveur via SSH en utilisant PuTTY ou Terminal. Si vous souhaitez installer Ollama localement, sautez cette étape et ouvrez simplement le terminal de votre système.

Important ! Si vous utilisez des distributions basées sur Red Hat Enterprise Linux comme CentOS ou AlmaLinux, remplacez apt par dnf.

Une fois connecté, suivez les étapes suivantes pour installer Ollama :

- Entrez la commande suivante pour mettre à jour le référentiel de votre serveur. Si vous utilisez des distributions basées sur Red Hat Enterprise Linux, comme CentOS ou AlmaLinux, remplacez apt par dnf.

sudo apt update

- Installer les dépendances externes – les logiciels dont Ollama a besoin pour fonctionner correctement. Voici la commande :

sudo apt install python3 python3-pip python3-venv

- Entrez la commande suivante pour télécharger et configurer Ollama :

curl -fsSL https://ollama.com/install.sh | sh

- Créez un environnement virtuel Python en exécutant cette commande :

python3 -m venv ~/ollama-webui && source ~/ollama-webui/bin/activate

- Exécutez cette commande pour configurer l’interface web d’Ollama. Vous pouvez également utiliser Ollama CLI, mais elle est compliquée et moins intuitive :

pip install open-webui

- Démarrez un terminal virtuel en utilisant Screen. Cela permettra à Ollama de continuer à fonctionner en arrière-plan même après la fermeture de la connexion SSH.

screen -S Ollama

- Exécutez Ollama en procédant comme suit :

open-webui serve

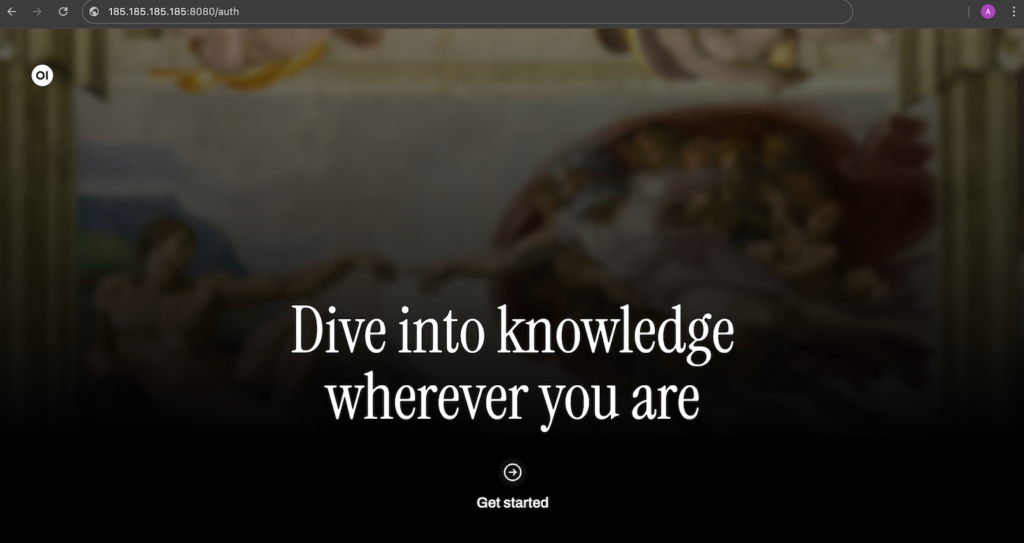

Voilà, c’est fait ! Maintenant, vous pouvez accéder à Ollama en entrant l’adresse suivante dans votre navigateur web. N’oubliez pas de remplacer 185.185.185.185 par l’adresse IP actuelle de votre VPS :

185.185.185.185:8080

2. Configurer DeepSeek

Après avoir confirmé qu’Ollama peut fonctionner correctement, configurons le DeepSeek R1 LLM. Pour ce faire, retournez à l’interface de ligne de commande de votre système hôte et appuyez sur Ctrl + C pour arrêter Ollama.

Si vous installez Ollama en utilisant le modèle de système d’exploitation de Hostinger, connectez-vous simplement à votre serveur via SSH. La façon la plus simple de le faire est d’utiliser le terminal de navigateur.

Ensuite, lancez cette commande pour télécharger le modèle Deepseek R1. Nous utiliserons la version 7b :

ollama run deepseek-r1:7b

Si vous prévoyez d’utiliser une autre version, comme la 1.5b, modifiez la commande en conséquence. Pour en savoir plus sur les différences et les exigences de chaque version, consultez la bibliothèque Ollama DeepSeek.

Attendez que votre système ait terminé le téléchargement de DeepSeek. La taille du fichier LLM étant d’environ 5 Go, ce processus peut prendre beaucoup de temps, en fonction de votre vitesse d’ accès à Internet.

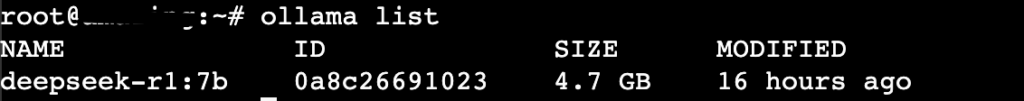

Une fois le téléchargement terminé, appuyez sur Ctrl + d pour revenir au shell principal. Ensuite, exécutez la commande suivante pour vérifier si DeepSeek est configuré correctement :

ollama list

Si vous voyez DeepSeek dans la liste des LLM d’Ollama, la configuration est réussie. Redémarrez maintenant l’interface web :

open-webui serve

3. Tester DeepSeek sur Ollama

Accédez à votre interface graphique Ollama et créez un nouveau compte. Cet utilisateur sera l’administrateur par défaut de votre agent IA.

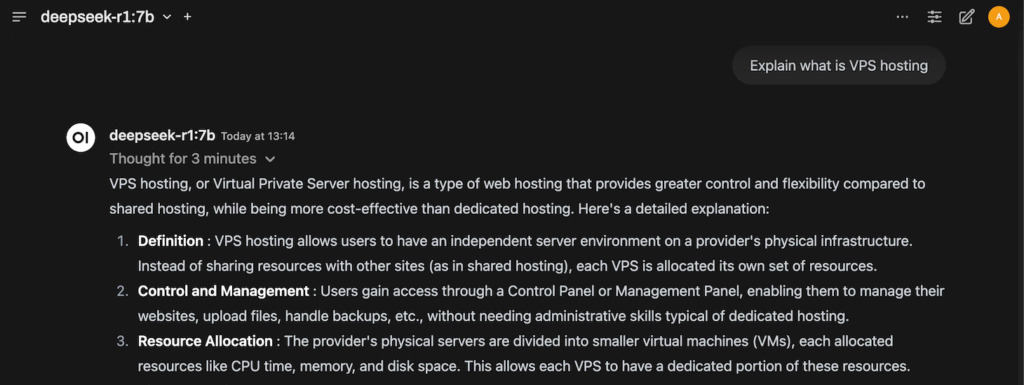

Une fois connecté, vous verrez le panneau de données principal où vous pourrez interagir avec DeepSeek. Lancez une conversation pour procéder à une vérification du bon fonctionnement du LLM.

Par exemple, posons la question suivante : “Expliquez ce qu’est l’hébergement VPS”. Si DeepSeek peut y répondre, le LLM et votre agent IA fonctionnent comme prévu.

Le temps de réponse de DeepSeek varie en fonction de la connexion Internet de l’hôte et de sa consommation de ressources.

4. Affiner Ollama

Bien qu’Ollama et DeepSeek fonctionnent parfaitement avec la configuration par défaut, vous pouvez affiner les paramètres du chat en fonction de votre cas d’utilisation.

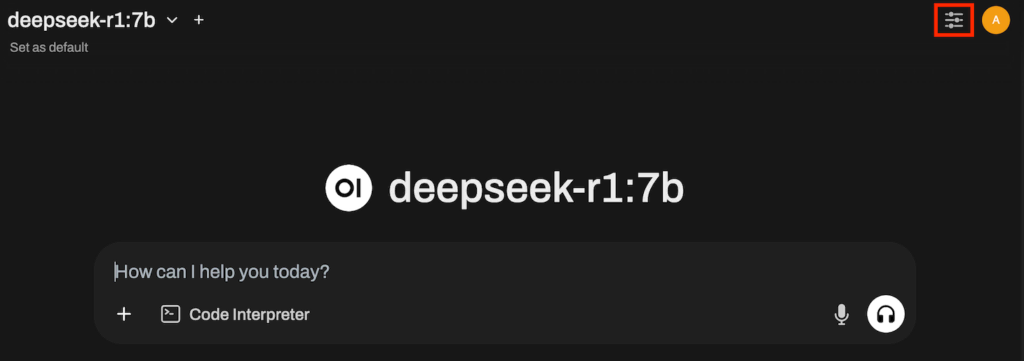

Pour accéder au menu, cliquez sur l’icône du curseur en haut à droite de votre tableau de bord Ollama, à côté de l’icône du profil. Dans la section Paramètres avancés, vous pouvez ajuster différents paramètres, notamment :

- Réponse au chat en continu – déterminez si votre agent d’intelligence artificielle répond ou non aux messages en temps réel. L’activation de cette option permet d’obtenir des réponses plus rapides, mais consomme davantage de puissance de calcul.

- Seed – permet à votre agent IA de générer la même réponse à une question spécifique lorsqu’elle est définie sur une valeur particulière. La valeur par défaut est random t.

- Température – définit le niveau de créativité de votre agent d’ intelligence artificielle. Une valeur plus élevée se traduira par des réponses plus innovantes et imaginatives.

- Effort de raisonnement – contrôle l’intensité de la réflexion du modèle d’IA avant de générer des réponses. La valeur, comprise entre 1 et 100, détermine le nombre d’itérations de raisonnement que le modèle effectuera avant de finaliser une réponse.

- Top K – réduit la probabilité de générer des non-sens. En fixant une valeur élevée, votre agent IA renverra des réponses très diverses, mais avec une forte probabilité d’hallucination.

- Max tokens – définit le nombre maximum de jetons que votre modèle d’IA peut utiliser. Plus la valeur est élevée, plus votre agent d’intelligence artificielle produira des réponses longues contenant des informations moins pertinentes.

Par exemple, si vous utilisez DeepSeek pour vous aider à écrire de la fiction, il peut être utile de définir une valeur de Temperature élevée. À l’inverse, vous souhaiterez peut-être la réduire et augmenter le Reasoning effort lors de la génération de code.

Si vous souhaitez en savoir plus sur les paramètres, les menus et la configuration, nous vous recommandons de consulter notre tutoriel sur Ollama GUI.

Conclusion

Ollama est une plateforme qui vous permet d’exécuter divers modèles de langage (LLM) open source sur votre serveur privé ou votre ordinateur afin de créer un agent d’IA personnel. Dans cet article, nous avons expliqué comment configurer le célèbre modèle d’IA, DeepSeek, sur Ollama.

Pour l’installer, vous avez besoin d’un système Linux avec au moins 4 cœurs de CPU, 16 Go de RAM et 12 Go d’espace de stockage. Une fois que vous disposez d’une machine répondant à ces exigences, installez Ollama et l’Open WebUI à l’aide du modèle de système d’exploitation de Hostinger ou des commandes.

Téléchargez DeepSeek pour Ollama via la ligne de commande. Une fois le téléchargement terminé, lancez la plateforme en exécutant open-webui serve. Maintenant, accédez au tableau de bord en utilisant l’IP de l’hôte et le port 8080.

Pour affiner la réponse d’Ollama en fonction de vos cas d’utilisation, modifiez les paramètres de configuration du chat. En outre, utilisez des techniques de prompting IA appropriées pour améliorer la qualité des réponses de DeepSeek.

Quelles sont les conditions requises pour utiliser DeepSeek avec Ollama ?

Pour utiliser DeepSeek R1 avec Ollama, vous avez besoin d’un système hôte Linux avec au moins un processeur à 4 cœurs, 16 Go de RAM et 12 Go d’espace de stockage. Vous pouvez utiliser des distributions populaires comme Ubuntu et CentOS pour le système d’exploitation. N’oubliez pas d’utiliser une version plus récente du système d’exploitation pour éviter les problèmes de compatibilité et de sécurité.

Qu’est-ce que DeepSeek et pourquoi devrais-je l’utiliser avec Ollama ?

DeepSeek est un LLM réputé pour être plus abordable et plus efficace que d’autres modèles populaires comme OpenAI o1, tout en offrant un niveau de précision similaire. En l’utilisant avec Ollama, vous pouvez mettre en place un agent d’IA personnel abordable qui tire parti des capacités du LLM.

Puis-je utiliser DeepSeek avec Ollama sur n’importe quelle version d’Ubuntu ?

En théorie, vous pouvez installer Ollama et exécuter DeepSeek sur n’importe quelle version d’Ubuntu. Cependant, nous recommandons d’installer l’agent AI sur une version plus récente du système d’exploitation, comme Ubuntu 20.04, 22.04 et 24.04. L’utilisation des nouvelles versions permet d’éviter les problèmes de compatibilité et de sécurité.